前言:头脑风暴里的三桩“电灯泡”

信息安全的危机往往像暗夜里的灯塔,只有在灯光闪烁、光束投射的瞬间,才让我们看清潜在的暗礁。今天,我以三则真实且极具教育意义的案例为起点,帮助大家在脑中点燃三盏警示之灯,进而引发对信息安全的深度思考。

案例一:隐形的AI模型——“看不见的盗版”

A 公司在推出新一代智能客服系统时,从公开的开源社区 Hugging Face 下载了一个最新的自然语言处理模型,随后将模型直接嵌入内部代码库。由于技术团队仅关注模型的功能实现,未对模型的许可证进行核查,更未在 Software Bill of Materials(SBOM) 中登记。数月后,A 公司因违反 MIT License 中的署名义务,被开源社区发起版权诉讼,导致项目被迫下线、品牌受损、合同违约金高达数百万元。

教育意义:即使是开源模型,也可能携带严格的许可证条款;未在 SBOM 中登记的组件相当于 “隐形炸弹”,随时可能引爆法律风险。

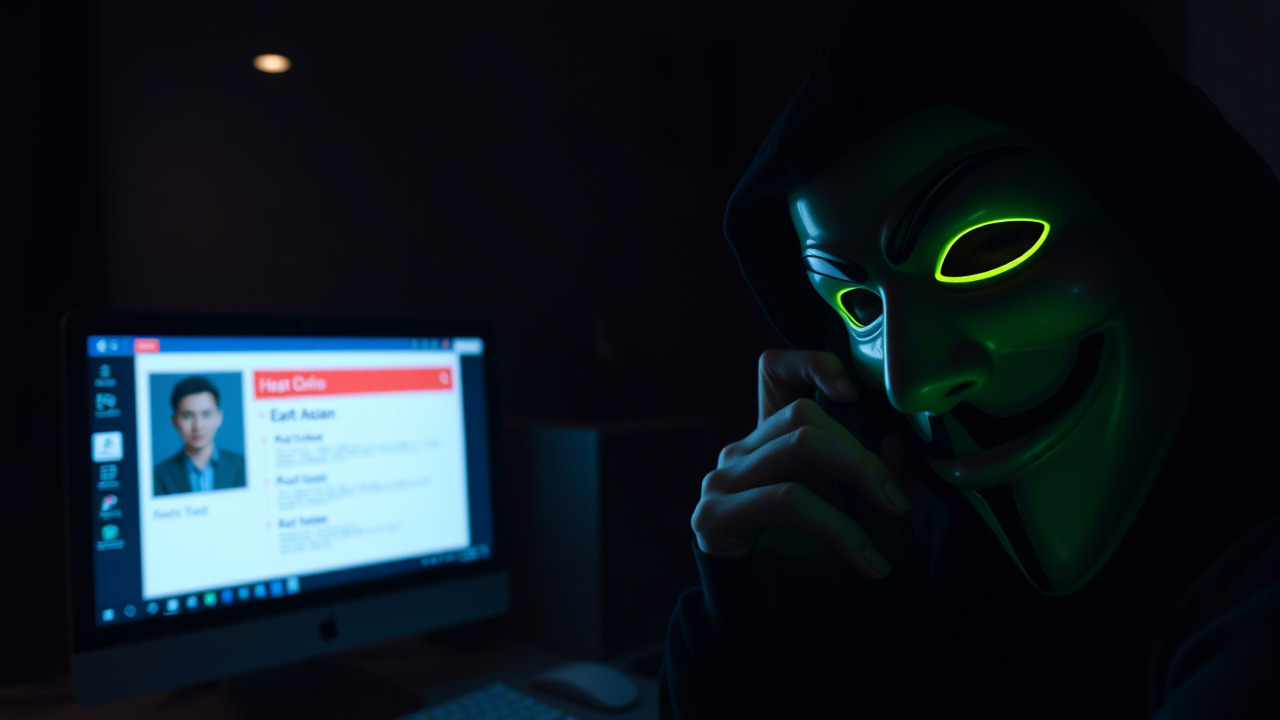

案例二:被“包装”成开源的恶意模型——“黑客的AI伪装”

B 企业在一次内部黑客演练中,意外发现一段隐藏在内部代码库深处的 TensorFlow 模型文件。表面上该模型标记为 GPL‑3.0 开源,但内部实现却植入了 “数据泄露后门”,可以在特定语义触发点将敏感客户信息加密后发送至攻击者控制的服务器。更糟的是,这段后门模型在 CI/CD 流程中被自动打包进生产镜像,最终在实际生产环境中导致了数千条用户隐私数据被盗。

教育意义:模型本身也可能被 obfuscation(混淆) 与 steganography(隐写) 手段隐藏恶意行为,安全团队必须使用 指纹(CodePrint)扫描 等技术,对模型进行深度解析与溯源。

案例三:合规盲区的代价——“AI法案的监管绊脚石”

C 公司在向欧盟市场推出 AI 驱动的图像审核系统时,未对所使用的 大规模预训练模型 的训练数据来源进行审计。因模型训练数据中包含受 GDPR 保护的个人照片,且未进行匿名化处理,欧盟监管部门依据 AI Act 对其发起行政处罚,处以 营业额 6% 的巨额罚款,并强制要求产品暂停销售,导致业务收入骤降、合作伙伴信任流失。

教育意义:在 AI Act、U.S. Executive Order on AI 等新兴监管框架下,企业必须对模型的 license、data provenance(数据来源) 与 risk assessment(风险评估) 进行全链路可视化,否则将面临合规绊脚石的沉重代价。

第一章:信息化、数字化、智能化的“三位一体”时代

“数之以理,律以以法”。——《礼记·大学》

当今企业正经历 信息化 → 数字化 → 智能化 的跨越式升级。传统的防火墙与杀毒软件已经难以覆盖 AI模型、容器镜像、微服务等新兴资产。我们必须认识到:

-

资产多元化:从代码到模型,再到数据集,每一环皆可能成为攻击面。正如 Black Duck 在 2025.10.0 版本中推出的 AI Model Risk Insights,通过 CodePrint 指纹技术,对 Hugging Face、GitHub 等平台的模型进行唯一标识,实现 “看得见、用得明、管得住”。

-

供应链复杂度:AI模型的依赖链条往往跨组织、跨国家,涉及 开源社区、第三方模型库、内部研发 多层次。任何一环的疏漏,都可能导致 供应链攻击(Supply Chain Attack)蔓延至全公司。

-

合规监管趋严:从欧盟 AI Act、美国 AI Executive Order 到中国 《数据安全法》、《个人信息保护法》,对模型的 许可、数据来源、风险评估 提出了明确要求。合规不再是“事后补救”,而是 “事前预防”。

因此,信息安全不再是 IT 部门的专属职责,而是全员的共同使命。每一位员工都是企业安全生态链上的关键节点,任何疏忽都可能导致链路断裂,引发巨额损失。

第二章:从案例到行动——我们该如何自救?

1. 建立全员可视化的 AI资产清单

- 使用指纹技术:借助 Black Duck 的 CodePrint,为每一个模型生成唯一指纹,确保即使模型被重命名、压缩或混淆,也能被精准识别。

- 完善 SBOM:在 Software Bill of Materials 中记录模型名称、版本、许可证、训练数据来源、使用场景等关键元信息,实现“一目了然”的资产视图。

- 定期审计:每季度组织 AI资产清查,对新增模型进行许可证合规性审查和数据来源合法性核查。

2. 强化 CI/CD 流程的安全审查

- 安全门槛:在 代码提交、镜像构建、部署 等关键节点,嵌入 AI模型扫描插件,自动触发 AI Model Risk Insights 检测。

- 拒绝隐蔽:对检测到的 未声明模型、混淆模型、高风险许可证 立即阻断流水线,返回给研发团队整改。

- 可追溯:保留 扫描报告 与 审计日志,满足合规审计需求。

3. 培养 安全思维 与 合规意识

- 安全文化渗透:将安全议题从技术层面升华为业务价值,鼓励员工在日常工作中提出“这里有没有潜在的模型风险?”的自检问题。

- 案例复盘:每月组织一次 安全事件复盘会,分享内部或行业最新案例,让“案例”成为“警钟”。

- 技能提升:提供 模型安全扫描、许可证解读、数据合规 等系列微课程,帮助员工快速掌握实用工具。

第三章:即将启动的 信息安全意识培训——你的参与意义何在?

1. 培训概览

- 时间:2025 年 12 月 10 日至 12 月 14 日(共5天,线上线下同步进行)。

- 对象:全体员工(研发、运维、产品、市场、财务、人事等部门),特别邀请 AI模型研发团队 与 合规审计团队 共同参与。

- 内容:

- AI模型安全基础:指纹扫描、代码指纹、Model Card解读。

- 许可证与合规:MIT、Apache 2.0、GPL、Creative Commons 等常见许可证的核心要点。

- 数据治理:数据来源审计、敏感数据脱敏、GDPR 与 AI Act 对比分析。

- 实战演练:通过 Black Duck 平台进行真实项目的模型扫描、风险评估与整改。

- 案例研讨:深度拆解本篇文章所列的三大案例,现场模拟应急响应。

2. 参与的三大收获

- 洞悉风险:通过指纹技术直接“看见”隐藏模型,提前捕捉潜在合规与安全漏洞。

- 提升能力:掌握 SBOM 编写、模型许可审查、数据溯源等关键技能,提升个人职场竞争力。

- 贡献价值:在企业安全防线中发挥关键作用,帮助公司规避巨额罚款与声誉危机,实现 “安全即价值” 的共赢局面。

“不积跬步,无以至千里;不积小流,无以成江海。”——《荀子·劝学》

只有每一位员工从 细节 做起,才能让企业的安全防线从 碎片 变为 整体,从 被动 走向 主动。

第四章:让安全成为业务的加速器

在数字化浪潮中,安全不再是阻力,而是 加速器。当我们能够在模型研发的每一步注入合规审查、在代码提交的每一次执行安全扫描、在产品发布的每一次合规备案时,就能实现:

- 快速迭代:安全事前介入,避免后期大规模返工,缩短研发周期。

- 市场信任:合规的 AI 产品更易获得监管部门与客户的认可,打开更广阔的国际市场。

- 成本节约:提前发现风险,省去因漏洞导致的补救费用、罚款与品牌修复支出。

因此,信息安全意识培训 不仅是一次学习体验,更是一次 业务价值的再造。让我们以本次培训为契机,把安全思维根植于每一次需求评审、每一行代码、每一次模型部署之中。

第五章:行动号召——从今天起,做信息安全的“守门员”

亲爱的同事们,

“防微杜渐,未雨绸缪。” 在信息安全的赛场上,每个人都是守门员。请你:

- 立即报名:登录公司内部学习平台,完成培训报名;未报名者请在本周五前完成。

- 主动自查:打开公司内部代码仓库,使用 Black Duck 提供的免费指纹扫描工具,对每一个 AI 模型进行一次自检。

- 分享心得:在内部安全社区发布自检报告与改进计划,互相学习、共同提升。

让我们用实际行动,构筑企业安全的“金钟罩”,让每一次创新都在合规与安全的护航下,飞得更高、更稳。

结语:安全不是技术的专利,更是每个人的责任。让我们在信息安全的星空里,点燃一盏盏明灯,用知识照亮前路,用行动守护未来。

昆明亭长朗然科技有限公司提供全球化视野下的合规教育解决方案,帮助企业应对跨国运营中遇到的各类法律挑战。我们深谙不同市场的特殊需求,并提供个性化服务以满足这些需求。有相关兴趣或问题的客户,请联系我们。

- 电话:0871-67122372

- 微信、手机:18206751343

- 邮件:info@securemymind.com

- QQ: 1767022898