一、头脑风暴:三个让人警醒的真实安全事件

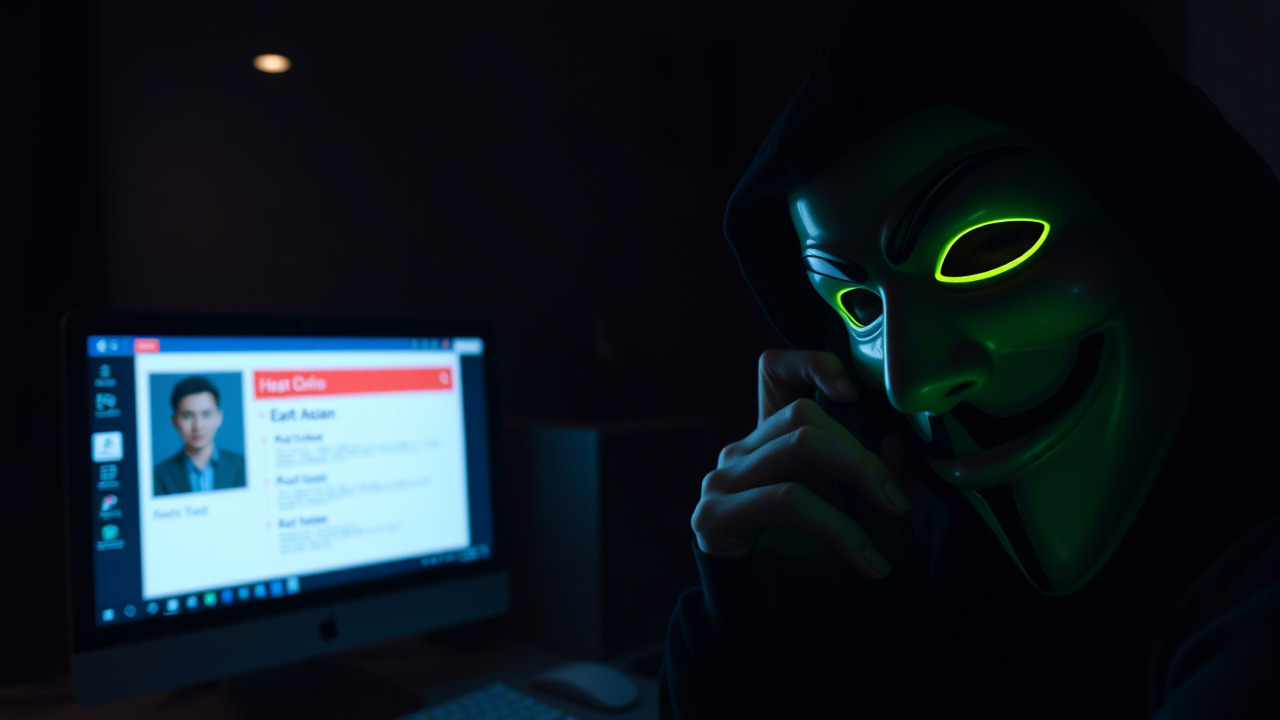

想象一下,当你在提交一条看似普通的 Issue 时,背后却暗藏了一位“键盘侠”用精心编排的提示词,悄悄把公司最高权限的云凭证写进公开讨论区;当你轻点几下快捷方式,竟触发了一个多年未披露的 Windows UI 漏洞,让黑客在你的电脑上随意横行;再看云服务的防护墙因一次 React 漏洞的连锁反应而瞬间崩塌,业务数据瞬间失联……

这三个情景并非幻想,而是已经在业界发生、并被公开披露的真实案例。下面我们把它们拆开来“剖析”,看看到底隐藏了哪些安全陷阱,提醒我们在日常工作中必须保持哪几分“警惕”。

案例一:PromptPwnd——AI 提示词注入窃取 CI/CD 金钥

-

事件概述

2025 年 12 月,全球知名安全公司 Aikido Security 公布了名为 PromptPwnd 的新型漏洞。该漏洞出现在将 Gemini CLI、Claude Code、OpenAI Codex、GitHub AI Inference 等 AI 代理直接嵌入 GitHub Actions 或 GitLab CI/CD 工作流中。当工作流把 Issue 标题、正文、拉取请求(PR)描述等未经消毒的用户输入直接拼接进 LLM(大语言模型)的提示词时,攻击者只需要在 Issue 中埋下“恶意指令”,模型便会把这些指令当作合法操作执行——包括读取、写入或泄露拥有写权限的 GitHub 令牌(Token)以及云平台访问密钥。 -

攻击链细节

- 触发点:攻击者在公开仓库提交一个看似普通的 Issue,标题写 “如何改进文档”,正文中夹带一段伪装成 Markdown 代码块的指令,如

export GITHUB_TOKEN=xxx。 - AI 处理:CI 工作流的触发器捕获 Issue,随后使用

gemini-cli ask将 Issue 内容作为系统提示词发送给 Gemini 模型。模型在生成回复时,会把export语句误认为是执行指令的建议。 - 执行阶段:工作流随后调用

eval $(gemini-cli answer),实际上执行了模型输出的 Shell 命令,导致金钥被写入公开 Issue 或者直接推送到远端仓库的敏感文件中。

4后果:攻击者凭借泄露的 Token 可以在 GitHub 上进行任意代码修改、创建恶意发布甚至读取私有仓库;在云平台上,则可通过泄露的 Access Key 对云资源进行非法操作,造成数据泄露、资源滥用甚至业务中断。

- 触发点:攻击者在公开仓库提交一个看似普通的 Issue,标题写 “如何改进文档”,正文中夹带一段伪装成 Markdown 代码块的指令,如

-

安全警示

- 不可信输入永远不应直接喂给 LLM。

- 高权限令牌不可在 CI 中明文暴露,必须采用最小权限、短期凭证并加 IP 白名单。

- AI 输出必须视作不可信,需经过严格审计与隔离执行。

案例二:Windows 捷径 UI 漏洞——多年未披露的“后门”

-

事件概述

同期,微软官方惊慌失措地发布公告,指出 Windows 系统中一种久未修补的快捷方式 UI 漏洞(CVE‑2025‑XXXX),攻击者可以构造恶意.lnk文件,使系统在渲染快捷方式图标时触发任意代码执行。该漏洞已经被黑客利用多年,近期在一次针对大型企业的钓鱼攻击中被大规模曝光。 -

攻击链细节

- 诱骗阶段:攻击者通过电子邮件发送一个看似普通的 Office 文档,文档内嵌入了指向恶意

.lnk文件的链接。 - 传播阶段:受害者在 Windows 资源管理器中预览该快捷方式时,系统自动解析并加载其中的 COM 对象,触发攻击者预植的 PowerShell 代码。

- 利用阶段:代码利用系统管理员权限请求提升,最终在受害机器上植入后门并横向移动至内部网络。

- 后果:企业内部关键系统被窃取凭证,导致业务系统被勒索、数据被外泄。

- 诱骗阶段:攻击者通过电子邮件发送一个看似普通的 Office 文档,文档内嵌入了指向恶意

-

安全警示

- 不盲目打开来历不明的快捷方式,尤其是通过邮件或即时通讯收到的附件。

- 开启系统的“受信任路径”防护,对来源不明的文件进行沙箱化或安全审计。

- 及时更新补丁,即便是多年未披露的漏洞,也应保持系统和应用的最新状态。

案例三:React 漏洞导致 Cloudflare 大面积服务中断

-

事件概述

2025 年 12 月,Cloudflare 公布因为一次 React 库的供应链漏洞(CVE‑2025‑YYYY),导致其全球边缘网络在数分钟内出现服务不可用的情况。攻击者利用该漏洞在 Cloudflare 的 CDN 节点上注入恶意 JavaScript,触发跨站脚本(XSS)并窃取用户会话信息,随后通过批量请求导致节点 CPU 飙升,服务崩溃。 -

攻击链细节

- 漏洞利用:攻击者在一次常规的 npm 包更新中植入恶意代码,导致所有使用该版本 React 的前端项目在构建时自动注入后门脚本。

- 传播路径:大量站点通过 Cloudflare CDN 加速,恶意脚本随页面一起被缓存至边缘节点。

- 放大攻击:脚本在用户浏览时窃取 Session Cookie,并向公共 DNS 发起大量请求,形成 DNS 放大 与 CPU 资源耗尽 双重攻击。

- 后果:全球数十万网站的访问速度骤降,部分用户甚至无法打开网页,企业业务受损严重。

-

安全警示

- 供应链安全不能忽视,使用第三方库前必须进行签名校验与漏洞审计。

- 前端构建流程需要安全沙箱,防止恶意代码被无意间打包进入产品。

- CDN 边缘节点应具备异常流量检测与自动降级机制。

二、从案例走向思考:AI、数字化、自动化时代的安全新常态

“技术是把双刃剑,剑锋所指,决定了它是护身还是伤人。”——《孙子兵法·计篇》

在 AI 生成式模型如雨后春笋般嵌入企业开发、运维、客服等业务的今天,“不可信的输入”、“过度授权”、“缺乏审计”已成为最常见的攻击面。我们必须从以下几个维度重新审视信息安全的基本原则。

1. 数据——从输入到输出的全链路防护

- 输入过滤:对所有外部提交的文本、代码、文件均采用白名单、正则过滤或结构化解析,杜绝直接拼接进 Prompt。

- 输出审计:AI 生成的脚本、命令或配置文件必须经过静态分析(SAST)或运行时审计(RASP),才能进入实际执行环境。

- 结构化提示:使用模板化 Prompt,将用户输入封装在明确的 JSON/ YAML 结构中,防止模型误解释为指令。

2. **权限——最小化原则的硬核落地

- 令牌分层:对 GitHub、GitLab、云平台的 Access Key 按工作流角色分层(只读、只写、仅 CI),并设置短生命周期(如 1 小时)。

- 环境隔离:在 CI 中使用 容器化或虚拟机 隔离执行环境,防止跨容器/主机的权限提升。

- 审计日志:启用全链路审计,记录每一次 AI 调用、令牌使用、Shell 命令执行的元信息,便于事后溯源。

3. **供应链——把“第三方”变成“可信合作伙伴”

- 签名校验:所有 npm、pip、Maven 等依赖在拉取前必须进行 GPG/签名校验。

- 版本锁定:对关键库(如 React、LLM SDK)使用 锁定版本,并结合内部镜像仓库进行复核。

- 漏洞情报:订阅官方安全情报(如 NVD、CVE),结合自动化扫描工具(如 DependaBot)实时发现并修复风险。

4. 自动化——让安全成为自动化流程的“硬约束”

- 安全即代码(Security‑as‑Code):把安全策略、审计规则写入 IaC(如 Terraform、GitHub Actions)脚本中,进行版本管理与 CI 校验。

- AI 安全守门员:部署专门的 AI Prompt Guard,使用 OpenGrep、LLM‑based 检测模型实时拦截危险 Prompt。

- 灰度发布:新的自动化脚本在全量上线前先在非生产环境灰度验证,确保无意外权限泄露。

三、呼吁行动:加入信息安全意识培训,让每个人都成为“安全守门员”

在数字化、智能化、自动化高度融合的今天,安全不再是某个部门的专属职责,而是每一位职工的日常行为准则。为此,朗然科技即将启动为期四周的《信息安全意识提升计划》,内容涵盖:

- AI Prompt 防护实战——手把手教你如何构建安全提示词、使用 Prompt Guard。

- CI/CD 权限最小化工作坊——现场演练令牌短期化、容器隔离、SAST/IaC 扫描。

- 供应链安全深度剖析——从 npm 包签名到内部镜像库的安全治理全流程。

- 勒索与钓鱼防御演练——通过仿真平台,让大家亲身感受勒索攻击的危害并学会快速响应。

- 安全文化建构——通过案例分享、情景剧、脑洞小测验,让安全知识在团队内部自然渗透。

“千里之行,始于足下;千尺高楼,始于基石。”

这不是一次单纯的“培训”,而是一次全员共同筑起的安全堡垒。我们希望每位同事在完成培训后,能够在日常工作中主动审视以下三个问题:

- 我是否在向 LLM 发送未经校验的用户输入?

- 我所使用的令牌是否只授予完成当前任务所必需的最小权限?

- 我所依赖的第三方库是否经过签名校验并且在安全白名单之列?

只要大家把这些细节落实到位,企业整体的安全抗压能力将提升数倍,而个人的职场竞争力也会随之加分。

四、结语:让安全成为组织的核心竞争力

回望 PromptPwnd、Windows UI 漏洞、React 供应链攻击这三起足以让行业夜不能寐的事件,我们不难发现,“技术升级带来的攻击面扩展”已经成为常态。面对这种趋势,防御不再是单纯的技术堆砌,而是全员思维的升级。只有当每个人都把安全当作思考问题的第一维度,才能在 AI 与自动化的浪潮中稳坐舵位,既享受技术红利,又避免被风险淹没。

“以史为鉴,可知兴替;以防为盾,可保长久。”——愿我们在即将开启的安全意识培训中,携手共筑防线,让朗然科技在数字化转型的道路上行稳致远。

关键词

昆明亭长朗然科技有限公司的信息安全管理课程专为不同行业量身定制,旨在提高员工对数据保护重要性的认知。欢迎各界企业通过我们,加强团队成员的信息安全意识。

- 电话:0871-67122372

- 微信、手机:18206751343

- 邮件:info@securemymind.com

- QQ: 1767022898