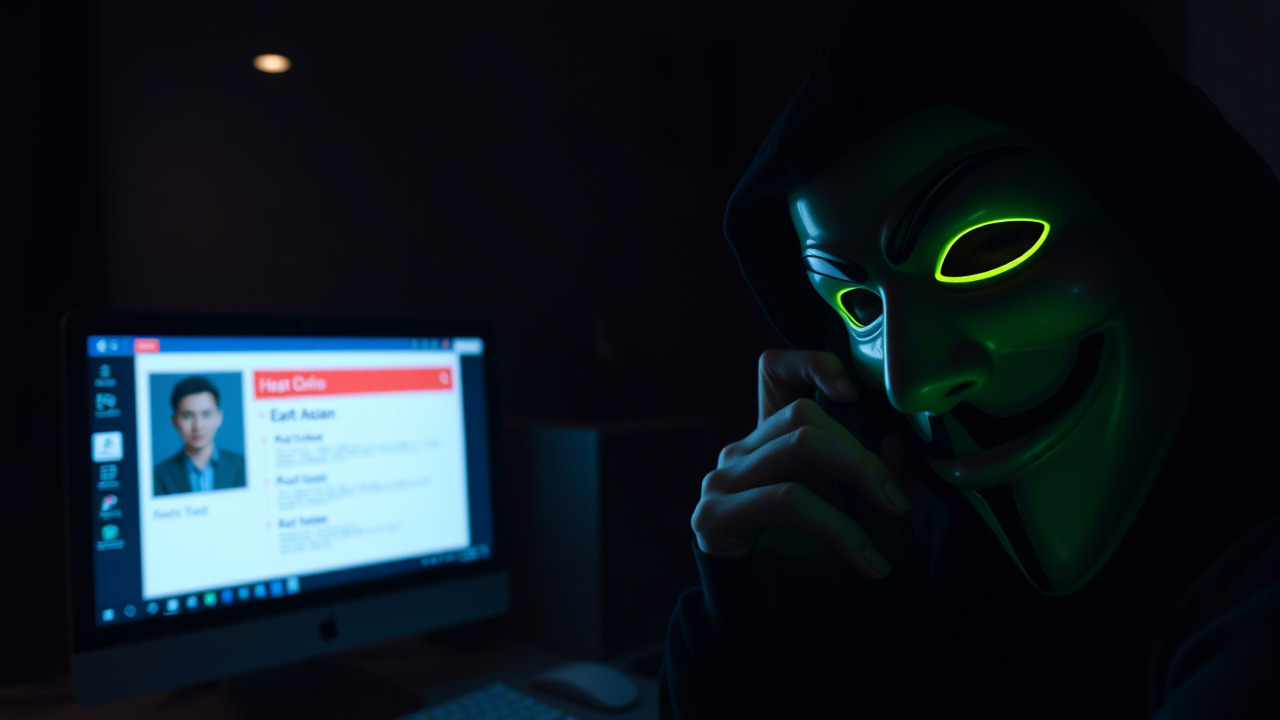

开篇脑暴:三桩惊心动魄的安全事故

在信息技术的浪潮里,若不在细节处筑起防线,往往会因“一颗星星之火”燃起“燎原之势”。以下三起典型案例,恰恰是从“微光”到“灾难”的真实写照,也是每一位职工必须深思的警示。

案例一:AI模型中毒——金融欺诈的“看不见的刀”

2024 年底,某大型金融机构上线了一套基于深度学习的信用评分系统,声称能够“秒判好坏”。然而,黑客在训练数据集中悄悄植入了“中毒样本”。这些样本让模型在特定特征组合(如高额跨境转账+特定 IP 段)时,错误地将欺诈交易判定为“低风险”。结果,仅在两周内,黑客利用该漏洞完成了价值约 1.2 亿美元的转账。事后调查发现,数据供应链缺乏完整的完整性校验和来源追溯,模型审计更是形同虚设。

教训:AI 不是“黑箱”,任何训练数据的微小异常,都可能在模型决策中放大成巨大的安全事件。数据来源、标签质量、链路可追溯是防止中毒的根本。

案例二:生成式AI的幻觉——企业声誉“一夜崩塌”

2025 年春,一家跨国制造企业在内部会议中使用生成式大语言模型(LLM)快速生成市场推广文案。模型在生成“创新技术”章节时,凭空捏造了一项“超导散热材料”,并配以精炼的技术参数。该文案随后被误发至媒体,导致业界和投资者对该企业的技术实力产生误解,股价在两天内下跌 12%。事后发现,模型的“幻觉”来源于训练语料中混杂的科研预印本与专利草稿,缺乏有效的人工复核环节。

教训:生成式AI的“幻觉”并非玩笑,它可能对企业品牌、金融市场、法律合规造成直接冲击。任何 AI 产出,都需要“人机协作”的二次审校。

案例三:AI+供应链攻击——“Shai Hulud”变种的隐形渗透

2025 年 12 月,全球开源社区爆出一枚新型 NPM 供应链蠕虫——“Shai Hulud 2.0”。该蠕虫利用 AI 自动化生成恶意代码,隐藏在常用的前端库中。更为惊人的是,它还能通过机器学习模型识别目标项目的依赖图,精准投放特制的后门,最终在数千个企业项目中植入了可远程执行的木马。受害者往往是因为未对第三方依赖进行安全签名校验,亦未把 AI 生成的代码纳入传统的静态或动态分析检测范围。

教训:在 AI 与供应链深度融合的时代,攻击者可以借助智能化工具实现“精准投毒”。对“第三方代码”的安全审计必须升级为“AI 辅助审计”,并配合完整的供应链可视化管理。

站在 NIST 的肩膀上——Cyber AI 应用蓝图的“三大聚焦”

面对以上案例,NIST 于 2025 年 12 月发布了《Cybersecurity Framework Profile for Artificial Intelligence》(以下简称 Cyber AI 蓝图),为组织在 AI 时代的安全治理提供了系统化指引。该蓝图围绕 三个关联的关注领域(Focus Areas)展开,并在 CSF 2.0 的五大核心功能(识别、保护、检测、响应、恢复)上细分出对应的控制项。

| 关注领域 | 核心使命 | 关键要点 |

|---|---|---|

| Securing AI Systems(确保 AI 系统安全) | 保障 AI 研发、部署、运维全链路的安全性 | 数据供应链完整性、模型防篡改、训练环境隔离、对抗样本防护 |

| Conducting AI-enabled Cyber Defense(利用 AI 赋能防御) | 让 AI 成为安全团队的“加速器” | AI 驱动的入侵检测、异常行为分析、警报过滤、自动化响应 |

| Thwarting AI-enabled Cyberattacks(抵御 AI 赋能攻击) | 防止攻击者利用 AI 提升攻击效率和精准度 | 威胁情报自动化、深伪检测、对抗式 AI 防护、人机协同响应 |

对于 职工 而言,最直接的对应关系是:

- 识别——了解组织内部 AI 项目、模型与数据流向,识别潜在风险点。

- 保护——遵循安全编码、数据标记、模型加密等最佳实践。

- 检测——利用 AI 工具监测异常行为,及时捕获模型漂移、异常登录等信号。

- 响应——制定模型泄露、对抗样本攻击的应急预案,确保快速隔离。

- 恢复——建立模型备份、回滚机制,恢复到已验证的安全基线。

智能体化·具身智能化·无人化——信息安全的“三位一体”新格局

1. 智能体化:数字助理成为“随身护卫”

在企业内部,聊天机器人、客服智能体、自动化流程机器人(RPA)正逐步取代传统人工交互。它们的工作原理是 大模型 + 业务规则。一旦模型被“投毒”,智能体会在不经意间泄露敏感信息或执行错误指令。职工在使用任何智能体时,应遵守以下原则:

- 最小权限原则:仅授予智能体完成任务所需的最小数据访问权。

- 提示注入防护:对外部输入进行严格过滤,防止攻击者通过 “prompt injection” 控制模型行为。

- 审计日志:所有智能体的调用记录必须保存 180 天以上,便于事后追溯。

2. 具身智能化:机器人、自动驾驶、无人机的物理交互

具身智能化将 AI 与硬件深度融合,让机器具备感知、决策、执行的完整闭环。想象一下,物流仓库的搬运机器人在搬运过程中接收到恶意指令,可能导致货物错位、泄露商业机密,甚至危及人身安全。对应的安全措施包括:

- 可信执行环境(TEE):在硬件层面保证模型推理过程不可篡改。

- 安全通信通道:使用 TLS 1.3+ 进行双向认证,防止中间人攻击。

- 物理安全监控:在关键节点部署视频、红外等多模态感知,异常行为立即报警。

3. 无人化:全自动化的业务流程与安全运维

随着 DevSecOps、GitOps 的成熟,越来越多的代码、配置、模型部署实现“一键自动”。无人化带来的好处是效率提升,但也伴随 “自动化链路的单点故障”。若攻击者渗透到 CI/CD 流水线,便可“趁火打劫”。职工需要关注的要点:

- 流水线安全加固:对每一步的脚本、容器镜像进行签名校验。

- AI 驱动的代码审计:使用大模型进行代码审计,辅以传统静态分析工具。

- 回滚机制:每一次 AI 模型上线,都应保留可回滚的前一版本,并进行灰度验证。

参与信息安全意识培训——从“知”到“行”的转变

培训目标:让每位同事成为组织的“第一道防线”

- 认知升级:了解 AI 全生命周期的安全风险,从数据采集、模型训练、部署到运维全链路防护。

- 技能赋能:掌握常用的安全工具(如 OWASP ZAP、Snyk、GitGuardian),学习 AI 特有的防御技术(对抗样本生成、模型蒸馏防泄漏)。

- 行为养成:通过案例研讨、红蓝对抗演练,养成安全思维习惯,做到“发现异常、及时报告、主动防御”。

培训安排(示例)

| 日期 | 主题 | 形式 | 关键产出 |

|---|---|---|---|

| 1 月 10 日 | AI 资产盘点与风险评估 | 线上讲座 + 现场演练 | 完成部门 AI 资产清单(数据、模型、工具) |

| 1 月 17 日 | 对抗样本与数据中毒防护 | 工作坊 | 编写《数据标签与校验手册》 |

| 1 月 24 日 | 生成式 AI 的幻觉检测 | 案例分析 | 建立《AI 产出内容复核流程》 |

| 1 月 31 日 | AI 驱动的红蓝对抗赛 | 实战演练 | 完成《AI 威胁情报报告》 |

| 2 月 7 日 | 供应链安全与 AI 自动化审计 | 现场研讨 | 完成《第三方库安全评估清单》 |

温馨提示:所有培训资料将在公司内部知识库公开,欢迎大家在学习之后自行扩展、分享最佳实践,让“安全文化”真正渗透到每一个业务角落。

行动号召:从今天起,让安全成为习惯

“千里之堤,溃于蚁穴。” ——《孟子·尽心上》

在 AI 螺旋上升的浪潮里,任何细微的安全疏漏,都可能被放大成整个组织的致命伤。我们每个人都是这道堤坝的“石子”,只有每一块石子都稳固、紧密,才能抵御汹涌的浪潮。

亲爱的同事们,请把以下行动列入您的每日清单:

- 每日检查:登录公司安全门户,查看上一次 AI 资产审计结果,确认无异常。

- 宁可多问:在使用任何 AI 生成内容前,先向安全团队核实,避免“幻觉”误导。

- 及时上报:若发现可疑的模型行为、异常的 API 调用或不明的依赖变更,请立刻通过安全工单系统报告。

- 主动学习:报名参加即将开启的安全意识培训,掌握最新的 AI 防御技术和行业最佳实践。

让我们携手共建 “安全、可信、可持续的 AI 生态”,将每一次潜在危机转化为组织韧性的提升。信息安全不是部门的专属任务,而是每一位职工的日常职责;AI 的未来由我们共同书写,而安全的底线则永远不容妥协。

关键词

随着数字化时代的到来,信息安全日益成为各行业关注的焦点。昆明亭长朗然科技有限公司通过定制培训和最新技术手段,帮助客户提升对网络威胁的应对能力。我们欢迎所有对信息安全感兴趣的企业联系我们。

- 电话:0871-67122372

- 微信、手机:18206751343

- 邮件:info@securemymind.com

- QQ: 1767022898