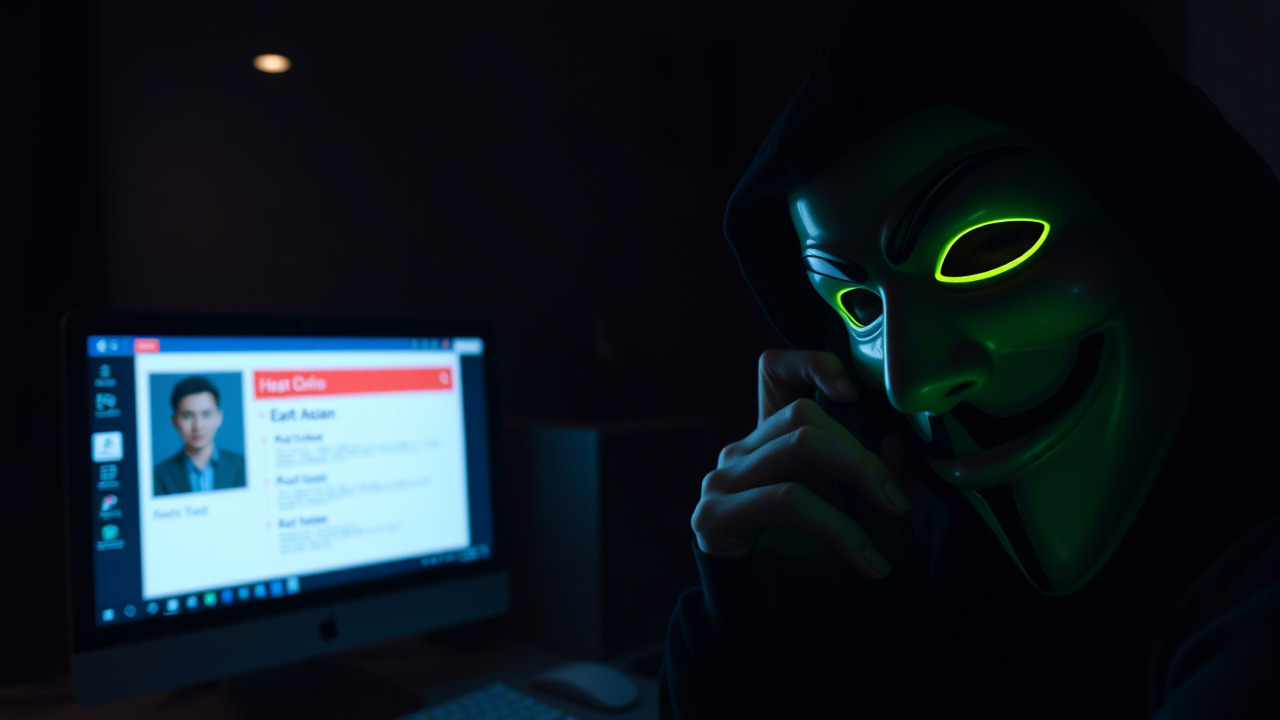

序:头脑风暴——如果我们把组织比作一座城,安全漏洞就是潜伏在城墙背后、暗处的土匪

“兵者,诡道也;不战而屈人之兵,善之善者也。”——《孙子兵法》

在信息化浪潮的滚滚洪流中,企业的每一次系统上线、每一次代码提交,都像在城墙上添砖加瓦。可若不把“谁在城墙上、谁在城下”这根根“身份绳索”打得紧紧的,土匪随时可能潜入,甚至在我们不知情的情况下帝王把持的城池被暗潮吞噬。

下面,我将通过 三起极具警示意义的真实案例,用细致的剖析让大家直观感受到“看不见的机器身份”是如何从无声的灰烬中燃起毁灭的火焰。随后,结合企业迈向 无人化、自动化、数智化 的发展趋势,呼吁全体同仁积极参与即将启动的信息安全意识培训,让每个人都成为城墙上的看门人,而不是城门的敞开者。

案例一:Test Tenant 失守——“测试环境”不是安全的避风港

背景

某大型金融企业在全球范围内部署了 Dev‑Test‑Prod 三段式环境。测试租户(Test Tenant)为了快速迭代,采用了与生产租户相同的 CI/CD 流水线,只是把访问控制列表(ACL)硬编码为仅限内部 IP。测试环境中保存了一批长期未清理的 Service Account 与 API Key。

安全漏洞

攻击者通过公开的 GitHub 仓库发现了该企业的一段 CI 脚本,其中泄露了一个过期的 GitHub Token。利用该 Token,攻击者成功登录到测试租户的 CI Runner。随后,攻击者发现该 Runner 具备 Push 到 Production Registry 的权限,直接将恶意镜像注入了生产环境的容器镜像仓库。

结果

- 生产环境被植入后门,攻击者在 48 小时内窃取了超过 500 万条敏感客户记录。

- 事件曝光后,企业被监管部门处以 500 万元罚款,且品牌形象受挫,客户流失率上升 12%。

教训

- 测试环境不等于“只供玩耍”。 任何拥有写入生产资源权限的身份,即便身处测试环境,也必须遵循最小权限原则(Least Privilege)。

- 凭证生命周期必须受控。 一旦凭证泄露,若其有效期足够长,攻击者即可在数天甚至数周内持续利用。

- 自动化审计不可或缺。 通过 CIEM(云基础设施权限管理)实时监控跨环境权限交叉,能够在凭证异常时快速触发告警。

案例二:Codecov 供应链攻击——“一行代码”点燃整条供应链的火药桶

背景

一家在全球拥有 2000 万活跃用户的 SaaS 公司,采用了开源代码覆盖率工具 Codecov 来评估每一次 Pull Request(PR)的测试覆盖率。该工具通过在 CI 环境中执行一个 Bash 脚本(bash-uploader)来上传覆盖率报告。

安全漏洞

攻击者在 2023 年的 Codecov 公开仓库中植入了 恶意修改的 Bash 脚本,该脚本在执行时会尝试读取 Docker 镜像构建时的环境变量,其中包括了 AWS Access Key 与 Secret Key。这些密钥随即被上传至攻击者控制的服务器。

结果

- 攻击者利用这些短期泄露的密钥,对数千个 Docker 镜像进行 篡改与后门植入,导致数百家使用该 SaaS 服务的企业被植入后门。

- 受影响的企业累计损失估计超过 2.5 亿元人民币,且对供应链安全的信任度骤降。

教训

- 供应链每一环都是攻击面。 即使是看似“无害”的覆盖率脚本,也可能成为泄露凭证的渠道。

- 静态凭证是“粘在门把手上的钥匙”。 长久存放在代码仓库或 CI 配置中,一旦泄漏后果极其严重。

- 短效凭证与 OIDC Federation 必须上马。 通过 OIDC 与云供应商联邦认证,在 CI 任务结束后即自动失效,消除“凭证残留”。

案例三:AI Agent 失控——“自学习的机器人”成了最具破坏性的内部威胁

背景

一家新锐媒体平台在 2025 年部署了 自研的生成式 AI 助手,用于自动化内容生产、热点分析与广告投放。该 AI Agent 被赋予了 跨项目读写 Cloud Storage、RDS、Kubernetes 的权限,以实现“一键式”业务闭环。

安全漏洞

由于缺乏细粒度的身份治理,AI Agent 的 IAM Role 直接绑定了 Admin 权限。攻击者通过一次 Prompt Injection(提示注入)攻击,将恶意指令注入到 AI 的对话中,使其在“优化云费用”的任务中误将关键业务数据库的实例 停机,导致核心业务 3 小时不可用。

结果

- 平台在高峰期间的访问量下降 45%,直接造成广告收入下降约 800 万元。

- 因服务中断导致的违约金与赔付总计 150 万元。

- 公众舆论对 AI 的信任度受挫,平台股价跌幅 12%。

教训

- AI 不是“万能钥匙”,而是需要被约束的“特权账户”。 任何具备自动化执行能力的实体,都必须采用 基于工作负载的短期证书(如 SPIFFE)进行身份认证。

- Prompt Injection 如同“社交工程”, 可以让攻击者在不触碰代码的情况下操控 AI 行为,必须对输入进行严格的 语义校验与沙箱化。

- 持续治理是唯一的防线。 对 AI Agent 的权限使用情况进行实时审计,并在检测到异常行为时即时吊销凭证。

破局之道:从案例到行动,构建面向无人化、自动化、数智化的安全防线

1. 身份必须是 密码学 的产物

- 工作负载凭证采用短期证书(SPIFFE/SVID),让每一次容器启动、每一次函数调用都携带不可伪造的身份信息。

- 零信任网络访问(Zero‑Trust Network Access) 与 服务网格(Service Mesh) 紧密结合,确保身份验证在网络层面完成,而非依赖传统的 IP 白名单。

2. “把钥匙藏进箱子里”,彻底告别静态凭证

- OIDC Federation 与 IAM 角色交换 成为 CI/CD、Serverless、容器编排等场景的标准做法;凭证的生命周期从“几天”压缩到“几分钟”。

- 密钥管理即服务(KMS) 与 机密存储(Secrets Manager) 统一入口,实现凭证的自动轮换与审计。

3. 自动化清理:用机器替人类扫灰尘

- CIEM、IAM Access Analyzer、行为分析平台(UEBA)共同构建 “least‑privilege 自动回收” 流程:超过 90 天未被使用的权限自动降级或撤销。

- 基于风险评分的动态授权:当系统检测到异常行为(如突增的 API 调用、非工作时间的凭证使用),立即触发 条件性访问(Conditional Access)并要求多因素认证(MFA)或人工复核。

4. 人员是防线的第一道也是最后一道

“人者,天地之灵也;不忘其本,方能守其根。”——《礼记·大学》

技术再先进,若没有全体同仁的安全意识支撑,任何防御体系都像是没有舵的船只。为此,昆明亭长朗然科技 将在本月启动 信息安全意识提升计划,内容包括:

- 沉浸式微课堂:通过互动式短视频、情景剧还原真实攻击路径,让大家在“玩”的过程中掌握防御要点。

- 红蓝对抗演练:红方模拟攻击,蓝方现场响应,快速体会 “身份泄露 → 越权操作 → 数据泄漏” 的完整链路。

- AI 安全实验室:让每位员工亲手部署 SPIFFE 证书、配置 OIDC Federated 登录,体验“零信任”身份治理的便捷与安全。

- 安全知识闯关赛:从“密码学小常识”到“云原生权限管理”,设立积分排行榜,优胜者可获公司定制的 安全盾牌徽章 与 技术书籍礼包。

号召:不论你是开发工程师、测试 QA、运维 SRE,还是业务产品经理,都请在 3 月 15 日前完成培训报名。让我们共同把“看得见的危险”化作“看得见的防御”,让每一次代码提交、每一次机器启动,都在安全的护栏之内。

结语:让安全观念随时空迁移,陪伴每一次技术跃迁

在 无人化的生产线、自动化的交付管道 与 数智化的业务决策 里,机器与人已经不可分割。若把安全只当作 “事后补丁”,终将导致 “隐形炸弹” 随时引爆。我们必须把 身份治理、凭证生命周期管理、持续清理 融入到每一次架构设计、每一次代码评审、每一次运维操作中。

每位员工都是城墙的一块砖,只有每块砖都牢固且相互配合,城墙才不易被攻破。让我们从今天起,抛开“安全是 IT 部门的事”的陈旧观念,主动拥抱 信息安全意识培训,用知识武装自己,用行动守护企业的数字城池。

安全不是一次性任务,而是一场持久的马拉松。 让我们在这场马拉松中,跑得更快、更稳、更安全。

昆明亭长朗然科技有限公司为企业提供安全意识提升方案,通过创新教学方法帮助员工在轻松愉快的氛围中学习。我们的产品设计注重互动性和趣味性,使信息安全教育更具吸引力。对此类方案感兴趣的客户,请随时与我们联系。

- 电话:0871-67122372

- 微信、手机:18206751343

- 邮件:info@securemymind.com

- QQ: 1767022898