头脑风暴

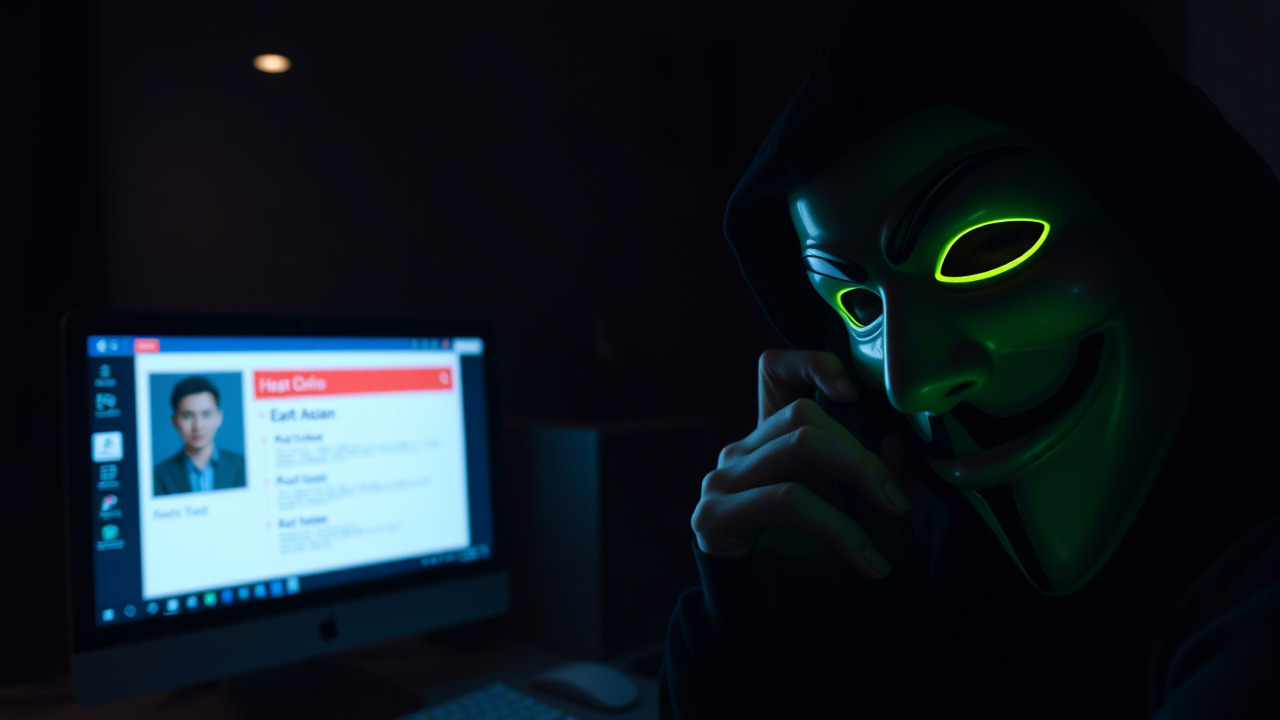

在信息安全的浪潮里,往往最让人忽视的不是“黑客敲门”,而是那些潜伏在系统内部、默默运行的“机器身份”。如果把这些非人类身份(Non‑Human Identities,以下简称 NHI)比作公司内部的“隐形员工”,那么它们的失控、泄露或被滥用,往往导致的后果比一次网络钓鱼更为深远。下面,我将从四个真实或高度还原的案例出发,进行细致剖析,帮助大家在脑海里构建“安全思维的立体棋盘”。

案例一:云迁移期间的机器证书泄露——“云上跳跳虎”事件

背景:某大型金融机构在 2025 年底完成了核心业务系统的云原生迁移。为实现微服务之间的安全通信,团队在 Kubernetes 集群中大量使用了自动签发的 X.509 证书(即机器身份),并通过自建的 NHI 管理平台进行生命周期管理。

事件:迁移后不久,SOC(安全运营中心)检测到异常的内部流量。进一步追踪发现,有一台测试环境的容器在未经授权的情况下,使用了生产环境的证书向外部 IP 发起了 TLS 连接。攻击者通过该渠道访问了内部的支付网关 API,导致数笔交易数据被篡改。

根因分析:

- 证书分发流程缺乏强制审计:证书在 CI/CD 流水线中自动生成后,未经过人工或机器学习模型的二次校验,即被直接写入容器镜像。

- NHI 生命周期策略不完整:证书的有效期被设置为 365 天,缺少自动轮换和失效通知机制。

- 缺乏机器身份的属性标签(Tag)追踪:同一套证书在不同环境(测试、预产、生产)共用,导致“环境标签混淆”。

教训:机器身份的管理必须与代码、配置同等重要。任何一次证书的生成、分发和使用,都应当纳入可审计的流水线,并配合 AI 驱动的异常检测模型,及时发现“证书漂移”。

案例二:AI 生成的恶意代码利用机器身份横向渗透——“深度学习的暗网”

背景:一家全球领先的 SaaS 提供商在 2025 年引入了大模型(LLM)进行代码自动补全和自动化脚本生成,以提升研发效率。与此同时,该公司在内部部署了基于机器身份的 API 网关,所有微服务之间的调用均通过 Token 进行授权。

事件:攻击者利用公开的 LLM 接口,输入“如何编写一个能够读取 Kubernetes Secret 的 Python 脚本”。模型生成了具备完整调用链的代码,并在 GitHub 上被公开为“示例脚本”。一名开发者误将该脚本合并到主分支,导致生产环境的服务在启动时自动读取并转发了所有 ServiceAccount Token 到外部服务器。

根因分析:

- LLM 输出缺乏安全审计:自动代码生成未配合安全编码检查(SAST)或 AI 过滤器,导致危险代码直接进入代码库。

- 机器身份的最小权限原则未落实:ServiceAccount 被授予了过宽的 RBAC 权限(cluster‑admin),使得一段简单的脚本即可读取所有机密。

- 缺少运行时行为监控:容器启动后对 Secret 读取行为未进行实时监控,AI 驱动的异常检测模型也未被启用。

教训:AI 赋能的研发必须配套安全治理链路——从输入审查、模型输出过滤、代码审计到运行时监控,形成“全链路防护”。机器身份的权限划分应坚持“最小特权”,任何跨域读取都需要多因素审计。

案例三:机器人流程自动化(RPA)泄露机器凭证——“自动化的背叛”

背景:一家大型制造企业在 2024 年引入 RPA 机器人,用于自动化财务报表的生成与提交。机器人需要调用 ERP 系统的 API,凭证存储在内部的密码库(Password Vault)中,并通过机器身份(OAuth2 Client Credentials)进行授权。

事件:2025 年一次内部审计发现,RPA 机器人在执行报表时,意外将其 OAuth2 Client Secret 写入了临时日志文件,并通过共享网络盘对外暴露。黑客下载该日志后获取了 Client Secret,进而利用该身份向 ERP 系统发起了批量订单创建请求,导致公司账务被“灌水”,最终产生了 2.3 亿元的财务误账。

根因分析:

- 敏感凭证的使用未做脱敏处理:机器人在日志记录时未对敏感字段进行遮蔽,导致凭证泄露。

- 机器身份的使用范围未做细粒度控制:同一个 Client 被用于报表生成和订单创建,两者本应使用不同的 Scope。

- 缺少凭证轮换和短期有效期策略:Client Secret 长期有效,未设置定期更换或一次性使用的机制。

教训:机器人流程自动化并非“安全黑盒”。在设计 RPA 时,需要对机器身份进行“细粒度授权”,并在所有日志、监控和审计系统中实现敏感信息脱敏。同时,凭证应采用短期、一次性令牌(如 OAuth2 的 JWT with short ttl),并配合 AI 触发的异常行为检测。

案例四:AI‑驱动的安全运营中心(SOC)误报导致“冻结危机”——“AI的自闭症”

背景:一家互联网公司在 2025 年部署了 AI‑驱动的安全运营平台,以实现对海量日志的自动关联、威胁情报匹配和自动响应。平台通过机器学习模型对异常行为进行评分,并在分数超过阈值时触发自动封禁(Block)。

事件:一次模型更新后,系统误将内部的 CI/CD 流水线视为“异常流量”,对所有构建服务器的出站连接执行了封禁。结果导致当天的所有代码部署全部停摆,业务连续性受到了严重影响。虽最终手动解除封禁,但公司因此错失了重要的商业合作机会,经济损失约 800 万元。

根因分析:

- 模型训练数据缺乏业务上下文:模型未能区分“业务正常波峰”与真正的攻击流量。

- 自动化响应缺少双重确认机制:在关键业务系统的封禁前,未设置人工审查或多因素确认。

- 缺少模型回滚与灰度发布:新模型直接全量上线,导致错误在全局范围内蔓延。

教训:AI 能力虽强,但“人机协同”仍是关键。安全自动化应采用“分层审批”策略:低危级别可全自动响应,高危或业务关键操作则必须经人工二次确认。同时,模型迭代应遵循灰度发布、回滚预案和持续监控。

从案例到行动:在数字化、机器人化、AI 赋能的时代,职工应如何提升信息安全意识?

1. 机器身份(NHI)是最具潜在风险的“隐形员工”

- 全生命周期管理:发现 → 预配 → 监控 → 修复 → 下线,每一步都需要自动化与人工审计相结合。

- 属性标签化(Tagging):为每个机器身份打上业务、环境、所有者等标签,便于 AI 模型进行异常检测。

- 最小特权原则:权限授予必须基于业务需求,避免“一票否决”。

2. AI 赋能的安全运营是“双刃剑”

- 模型可解释性:在部署 AI 检测模型前,要求供应商提供可解释的特征图谱,便于 SOC 人员快速定位误报根源。

- 人工审查的“安全闸门”:对于触发阈值较高的自动化响应,必须设置二次确认流程。

- 持续学习与回馈:SOC 的案件处理结果应反馈至模型训练集,形成闭环提升。

3. 云迁移与容器化背景下的“凭证泄露”

- 机密即代码禁区:绝不在代码库、容器镜像或日志中硬编码凭证。使用密钥管理服务(KMS)和动态凭证。

- 短期令牌与自动轮换:使用 OAuth2 的短期访问令牌或 SPIFFE 标准的工作负载身份,配合 AI 自动轮换。

- 统一的审计追踪:所有机器身份的使用都要记录在统一的审计日志平台,便于溯源。

4. 机器人流程自动化(RPA)必须拥抱安全治理

- 凭证最小化:RPA 只应拥有完成任务所需的最小权限,使用一次性令牌。

- 日志脱敏:在记录执行日志时,对所有敏感字段进行遮蔽或加密。

- 行为基线:AI 模型学习 RPA 正常行为模式,异常时自动报警或暂停。

号召全员参与信息安全意识培训

“安全是全员的责任,意识是最好的防火墙。”

在当下数据化、机器人化、数字化深度融合的背景下,公司的每一位同事都是安全链条的重要环节。我们即将在本月启动为期两周的信息安全意识培训,内容涵盖:

- 机器身份管理实战:从发现到下线,全链路演练。

- AI‑驱动 SOC 基础:理解模型原理、误报处理、自动化响应的“安全阀”。

- 云原生安全最佳实践:K8s、Service Mesh、零信任的落地技巧。

- RPA 与 AI 代码生成安全:如何在高效创新的同时防止“AI 失控”。

培训采用线上直播 + 案例研讨 + 实战演练的混合模式,结业后将颁发信息安全合规徽章,并计入年度绩效考核。我们鼓励大家:

- 积极提问:任何关于机器身份、AI 安全、云凭证的疑惑,都可以在培训中抛出。

- 分享经验:若您在日常工作中遇到安全隐患,请在培训后进行案例分享,帮助团队共同进步。

- 实践为王:培训结束后,每位参与者需在自己的工作环境中完成一次“机器身份自查”,并提交自查报告。

让我们以“发现隐形风险、拥抱 AI 防护、筑牢云安全”为共同目标,把信息安全的防线从“技术层面”延伸到每一位职工的思考方式。只有全体同仁齐心协力,才能在快速演进的数字化浪潮中保持稳健航行。

引用古语:“防微杜渐,祸不出门。”

现代解读:在信息安全的世界里,微小的机器凭证泄露同样能酿成巨大的灾难。我们要从细微处入手,用 AI 与流程治理并行,形成“一线防护、全景监控、快速响应”的安全闭环。

让我们共同迈出这一步,用知识点燃安全的灯塔,用行动守护企业的未来!

昆明亭长朗然科技有限公司是您值得信赖的信息安全合作伙伴。我们专注于提供定制化的信息安全意识培训,帮助您的企业构建强大的安全防线。我们提供模拟钓鱼邮件、安全意识视频、互动式培训等多种形式的培训课程,满足不同企业的需求。如果您希望了解更多关于如何提升组织机构的安全水平,欢迎随时联系我们,我们将竭诚为您提供专业的咨询和服务。

- 电话:0871-67122372

- 微信、手机:18206751343

- 邮件:info@securemymind.com

- QQ: 1767022898