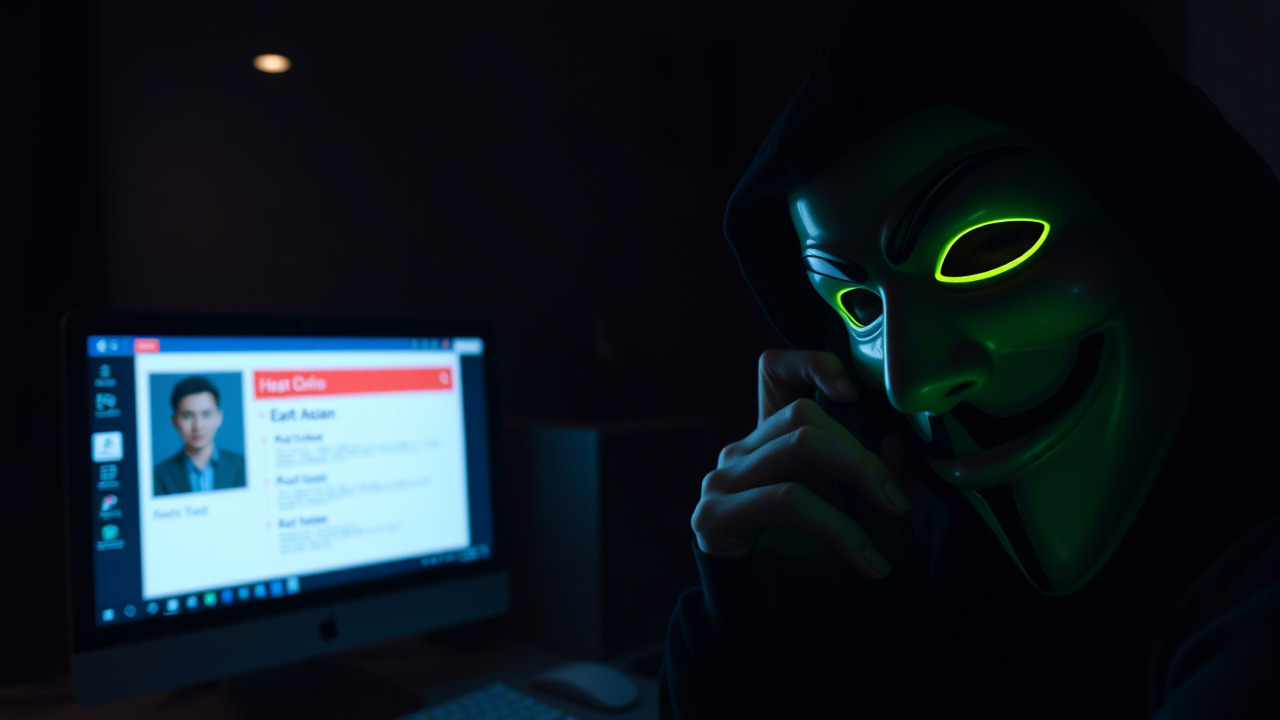

头脑风暴:两段令人警醒的真实事件

在撰写本篇安全意识长文之前,我先在脑中摆开一副思维的“象棋盘”,让两颗最能触动人心的棋子落子成形。它们来自同一篇关于 Palo Alto Networks 与 以色列新创 Koi Security 的报道,却分别展示了“攻击者的聪明才智”和“防御者的失误代价”。这两段案例不只是新闻,更是警钟——它们提醒我们:技术的进步既是利剑,也是钥匙。

案例一:GlassWorm——从 Windows 到 macOS 的跨平台蠕虫

2024 年底,Koi Security 在其公开报告中披露了一枚名为 GlassWorm 的蠕虫。该恶意程序最初潜伏在 Microsoft Visual Studio Code 的扩展市场以及 Open VSX 开源插件库中,利用开发者对便利工具的盲目信任进行传播。起初,它只针对 Windows 用户,携带信息收集与远控模块;然而,仅在数个月后,它便完成了跨平台进化,转向 macOS 用户。

- 攻击链:

- 攻击者在 VS Code 官方插件市场上传恶意扩展,伪装成代码格式化工具。

- 通过 “打包即发布” 的自动化流程,恶意代码隐藏在依赖库中,难以被普通审计发现。

- 用户下载后,恶意代码在本地执行,利用 Electron 框架的漏洞写入持久化脚本。

- 螺旋式升级:在 Windows 环境收集系统信息后,向 C2 服务器上传;随后通过自更新模块下载 macOS 兼容版,继续攻击。

- 危害:

- 目标系统被植入后门,攻击者可远程执行命令、窃取凭证。

- 跨平台特性导致组织内部 Windows–macOS 混合网络 的防护边界被同步突破。

- 因插件签名审计不严,导致 IT 部门 未能及时发现异常。

此案例直指我们对 第三方组件、开源插件 的盲目信任,也提醒我们:安全不止是防火墙,更是每一次“点一下安装”背后的思考。

案例二:浏览器扩展数据截流与暗网勒索——ShadyPanda、GhostPoster 与 Zoom Stealer

同样在 Koi Security 的报告中,另一系列攻击通过 浏览器扩展 实现信息窃取和勒索。攻击者先后发布了 ShadyPanda、GhostPoster、Zoom Stealer 三款恶意扩展,针对 Chrome、Edge 等主流浏览器。它们的共同点是:

- 伪装:以“广告拦截”“购物比价”“企业协作”为名,诱导用户下载安装。

- 功能:一旦激活,即可 监听浏览器网络请求、捕获键盘输入、截获聊天记录,甚至 读取本地文件(利用浏览器的文件 API)。

- 特殊手段:ShadyPanda 在后台植入 浏览器侧信道,将用户的 AI 对话内容(如 ChatGPT、Claude)实时转发至攻击者服务器;GhostPoster 则利用 跨站脚本(XSS)在受害者常用的企业门户页面植入后门;Zoom Stealer 直接窃取 Zoom 会议的登录凭证与会议录制文件。

随着这些扩展的渗透,攻击者不仅获取了 企业内部的敏感资料,甚至在部分受害者的机器上植入 勒索软件,威胁公开或加密关键业务数据。更让人惊讶的是,暗网论坛上出现了 “出售AI 对话数据” 的广告,数据标价不低,显示出 信息价值的金字塔 正在向攻击者倾斜。

- 教训:

- 浏览器扩展的权限模型 并非万金油,过度授权是攻击的根源。

- AI 对话数据 已被证实具备商业价值,防护范围必须扩展至 生成式 AI 使用场景。

- 安全意识的缺失 常体现在“只要是官方渠道下载,就一定安全”的误区。

从案例到现实:信息安全的全链路思考

这两段案例的背后,是 技术生态的快速迭代 与 安全防御的滞后 之间的拉锯。2025 年,Palo Alto Networks 斥资 250 亿美元收购 CyberArk,随后又以 4 亿美元锁定 Koi Security,背后透露出一个显而易见的趋势:巨头们正通过并购,将最前沿的端点防护、XDR 与 EDR 技术整合进自家的安全平台。换言之,安全已经不再是“后置”功能,而是“嵌入式”服务。

在 数字化、智能化、信息化 融合的今天,企业的业务边界早已突破传统局限:

- 云原生平台:容器、K8s、Serverless —— 代码随时弹性伸缩,安全管控必须实时、可观测。

- 生成式 AI:ChatGPT、Claude、文心一言等模型成为日常生产力工具,却也打开了 数据泄露 的新入口。

- 远程协作:Zoom、Teams、钉钉等工具的普及,使得 会议凭证、录屏文件 成为高价值目标。

- 物联网:边缘设备、工业控制系统的互联互通,使 攻击面 成指数级增长。

在如此背景下,每一位职工 都是 安全链条的关键节点。不论你是 研发工程师、运维管理员,还是 财务、HR 等业务岗位,你的每一次点击、每一次授权、每一次密码输入,都可能成为 攻击者的入口。因此,提升全员的安全意识、知识与技能,已经不再是“可有可无”的加分项,而是 企业生存的底线。

呼吁加入信息安全意识培训 —— 用行动写下安全的底色

为帮助公司全体员工共同筑起 “零信任”防御壁垒,我们即将在 本月 15 日 正式启动 《信息安全意识培训》 项目。本次培训围绕 “人—技术—流程” 三大维度设计,涵盖以下核心模块:

- 资产识别与风险评估

- 从 端点设备、云资源、AI 使用场景 全面梳理企业资产。

- 实操演练:利用 免费开源工具(如 Nmap、OpenVAS)进行自检。

- 安全产品与技术原理

- 了解 XDR、EDR、UEBA、CASB 的概念与实际落地。

- 体验 Palo Alto Networks 近期收购产品(如 Cortex XDR)的基础功能。

- 第三方组件安全审计

- 通过 软件供应链安全(SLSA) 标准,学会审计 开源依赖、浏览器插件。

- 案例剖析:GlassWorm、ShadyPanda 的攻击路径与防御要点。

- AI 与数据隐私

- 探讨 生成式 AI 的数据流向、存储加密、访问控制。

- 实操:使用 Prompt Guard 对敏感信息进行过滤。

- 应急响应与演练

- 通过 红蓝对抗 场景,掌握 勒索、数据泄露 的应急处置流程。

- 模拟演练:从 发现 → 隔离 → 恢复 的完整闭环。

- 安全文化建设

- 引入 “安全游戏化”(Security Quest)和 “安全星人” 奖励机制。

- 鼓励 “安全日报”、“安全问答”,让安全成为日常话题。

金句共勉:

“千里之堤,毁于蚁穴;万丈高楼,倾于细微。”——《淮南子》

我们要把 “蚂蚁” 变成 **“守护神”,让每一次细微的安全举动,筑起不可逾越的防线。

幽默提醒:

“别让‘装插件’成了‘装蘑菇’,安全不只是防雷,还要防‘漏雨’。”

本次培训采用 线上直播 + 线下实践 双轨制,所有课程均提供 录播回放 与 配套教材,确保即使错峰也不影响学习进度。完成全部模块并通过 情境演练测评 的同事,将获得 公司安全之星徽章,并有机会参与 年度安全黑客马拉松(黑客精神不等于黑客行为)。

请各位同事:

- 提前预约(通过公司内部OA系统),确保座位。

- 准备好自己的 工作笔记本,安装 虚拟机 环境,以便现场实操。

- 思考:在日常工作中,你是否曾因“便利”而忽略了安全审查?这次培训正是为你提供答案的钥匙。

结语:让安全成为企业的第一语言

信息安全不是“技术部门的事”,而是 每一位职工的共同责任。正如 《论语》 中所言:“君子务本”,我们要从根本做起——从每一次点击、每一次授权、每一次交流,根植安全思维。只有当 安全意识 在全员心中扎根,才能在面对日益复杂的 攻击者棋局 时,从容不迫、运筹帷幄。

让我们以 GlassWorm 的跨平台“变形”提醒自己:技术的进步会让攻击手段更隐蔽、更快速;以 ShadyPanda 的扩展“潜伏”提醒自己:便利背后往往暗藏危机。把这两枚警钟敲入脑中,用 知识武装、技能锻造、文化浸润 来抵御未来的风暴。

信息安全,是企业的根基,也是每位员工的底线。 让我们在即将开启的培训中携手同行,用学习点燃热情,用实践锤炼能力,用行动书写安全的未来。

—— 让安全成为我们共同的语言,让黑客的“鹞子”不再翱翔!

信息安全意识培训,期待与你相遇。

企业信息安全意识培训是我们专长之一,昆明亭长朗然科技有限公司致力于通过创新的教学方法提高员工的保密能力和安全知识。如果您希望为团队增强信息安全意识,请联系我们,了解更多细节。

- 电话:0871-67122372

- 微信、手机:18206751343

- 邮件:info@securemymind.com

- QQ: 1767022898