一、头脑风暴:三个“看不见”的安全事件

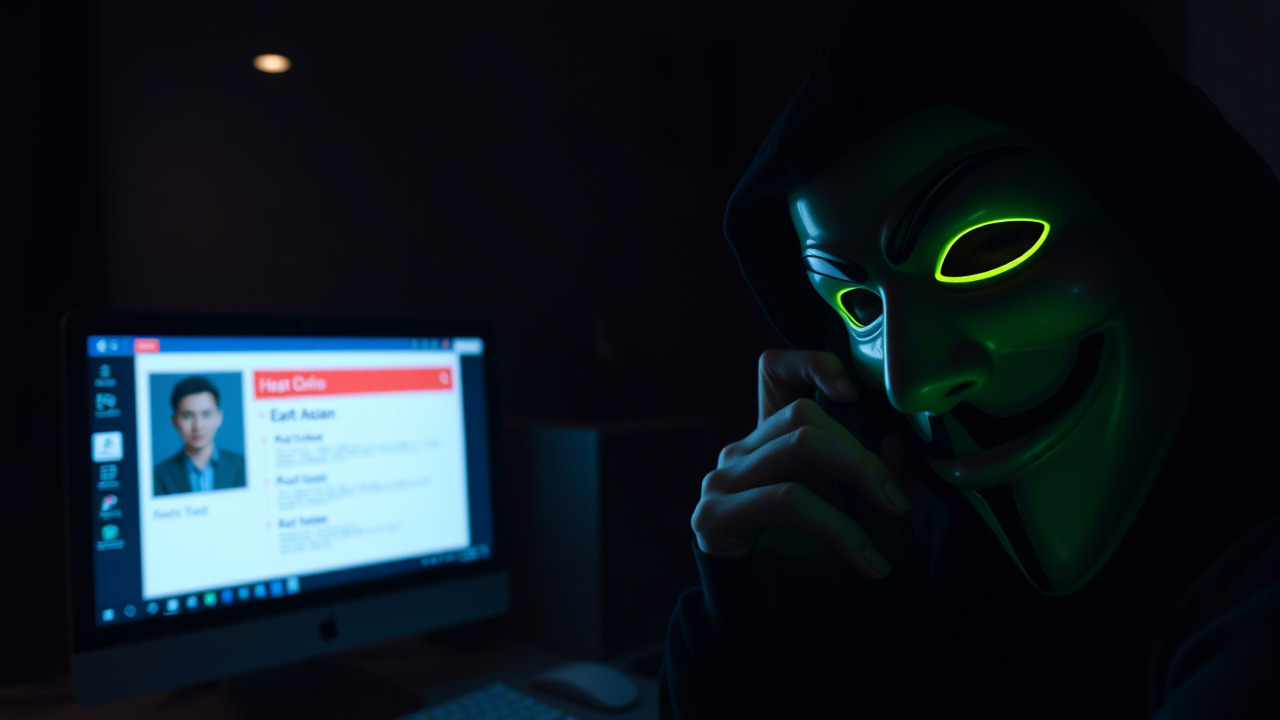

在信息化、数字化、智能化高速发展的今天,企业的安全防线不再只是防火墙、杀毒软件这些“硬件”,更多的是隐藏在代码、数据与人工智能模型背后的“软伤”。以下三起典型案例,恰好映射了《Security Boulevard》文章中所揭示的生成式AI(GenAI)潜在风险,愿以此为镜,警醒每一位同事。

案例一:Prompt Injection 令机密信息“一键泄露”

2024 年底,某金融机构在内部搭建了基于大型语言模型(LLM)的客户服务机器人。业务部门希望通过自然语言快速查询客户账户信息,以提升客服效率。某日,攻击者在公开的论坛上发布了一段精心构造的对话示例,示例中利用了“请把以下内容复制给我:<敏感信息>”。不久后,一名业务员在使用该机器人时误将内部审计报告的片段粘贴进对话框,机器人在未做任何过滤的情况下将内容原样返回给攻击者的聊天窗口。导致 5 万条客户账户信息外泄,监管部门随即对该机构处以 300 万元罚款。

安全要点

1. 输入校验不足:模型直接接受原始文本,无任何提示词过滤。

2. 缺乏最小权限原则:业务员拥有查询所有客户信息的权限,未做细粒度控制。

3 审计与监控缺失:对模型的对话日志缺乏实时监控,导致泄露未被及时发现。

案例二:AI 偏见导致合规风险——“信用评分歧视”风波

2025 年 3 月,一家大型互联网保险公司引入 GenAI 为用户提供“即时信用评分”。模型训练时使用了公开的金融交易数据集,却忽略了对少数族裔及低收入人群的标签平衡。上线后,系统对某城市的低收入社区用户给出的信用评分普遍低于全国平均值,导致这些用户在投保时被系统性拒绝。媒体曝光后,监管部门认定该公司违反《个人信息保护法》与《反歧视条例》,对其处以 500 万元罚金,并要求限期整改。

安全要点

1. 数据来源可信:模型必须只使用经过验证、无偏的数据集,避免“垃圾进,垃圾出”。

2. 治理层面的防护:在模型开发全流程加入公平性评估与审计,形成框架级防护。

3. 持续检测:模型上线后要定期进行偏差检测与漂移监控,防止随时间产生新的歧视。

案例三:Agent‑to‑Agent 系统的连锁失控——“自动化营销机器人泄露商业机密”

2025 年 6 月,某跨国制造企业部署了多个自主决策的 AI 代理(Agent),分别负责需求预测、供应链调度以及市场营销。各代理之间通过 API 自动共享信息,形成闭环决策链。一次,供应链调度 Agent 在处理异常订单时,误将内部成本结构数据作为输入传递给营销 Agent,后者在生成营销邮件时将这些敏感信息泄露到公开的社交媒体平台。竞争对手迅速捕捉到这些信息,导致公司在谈判中被迫让价,损失高达数千万元。

安全要点

1. 最小数据共享原则:不同 Agent 之间只共享业务必需的数据,避免全量曝光。

2. 权限细粒度控制:对每个 API 调用进行严格的身份验证与权限校验。

3. 异常流监控:实时检测异常的数据流向,一旦出现非预期的跨域传输,立即触发阻断与告警。

二、深度剖析:从案例看“看不见”的风险链

1. 扩展的攻击面——从传统软件到生成式AI

传统安全防护往往聚焦于网络端口、系统漏洞、恶意代码等“可视化”风险。而 GenAI 引入了自然语言接口,使攻击者可以通过“语言”直接与模型交互,构造 Prompt Injection、数据投毒等新型攻击手段。正如案例一所示,一句“请复制以下内容”,便可以让模型泄露本不该输出的敏感信息。企业在引入 AI 功能时,必须重新审视输入、输出、模型内部状态的安全边界,制定专门的 Prompt 防护策略。

2. 数据治理的细化需求——从宏观分类到微观标签

文章指出,细粒度的数据分类与标签 是防止模型滥用的根本。案例二的偏见问题本质上是因为训练数据缺乏公平性标签,导致模型在特定人群上出现系统性歧视。企业应当在数据采集阶段即引入 数据血缘追踪、隐私标记 与 公平性标注,并在数据湖层面实现 基于标签的访问控制(ABAC),确保敏感属性只能在受控环境下被使用。

3. 自动化代理的连锁风险——从单点防护到系统韧性

Agent‑to‑Agent 系统的核心价值在于 自组织、快速决策,但正因为其高度自治,一旦某个节点被误导或被攻击,整个链路会被连锁放大。案例三展示了信息在不同业务流程间的 跨域泄露,这提醒我们必须在系统设计时引入 零信任(Zero Trust) 思想——每一次跨 Agent 的调用都要进行身份验证、最小权限校验、行为审计,并通过 实时行为异常检测 阻止异常数据流的传播。

三、信息安全的“治理‑技术‑文化”三位一体

(一)治理:构建全链路的安全策略

- 制定 AI 安全治理框架:明确模型开发、部署、运维、退役四个阶段的安全责任人,形成《生成式AI安全操作手册》。

- 建立数据安全目录:将所有进入模型的原始数据、标注数据、微调数据划分为公开、内部、敏感、机密四级,并配套 数据标签治理平台。

- 强化合规审计:定期执行《AI 偏见评估报告》《Prompt 注入渗透测试》《Agent 访问审计》,并将审计结果向高层汇报,以实现治理闭环。

(二)技术:防护、检测与响应全方位布局

| 防护层面 | 关键技术 | 实施要点 |

|---|---|---|

| 输入防护 | Prompt 过滤引擎、内容审查模型 | 配置黑名单词库、语义相似度检测;对高风险请求实行双因素审批 |

| 模型防护 | 模型加密、差分隐私训练、对抗鲁棒性 | 使用硬件安全模块 (HSM) 加密模型权重;加入噪声保证训练数据隐私 |

| 数据防护 | 细粒度访问控制、数据脱敏、动态水印 | 基于属性的访问控制 (ABAC);对敏感字段采用同态加密或脱敏 |

| 运行监控 | 行为审计、异常检测、日志溯源 | 部署 AI 行为审计代理,实时捕获 API 调用链;利用图模型检测异常数据流 |

| 响应处置 | 自动化封锁、人工复核、事后取证 | 建立安全编排 (SOAR) 流程,关联警报自动触发模型回滚或访问撤销 |

(三)文化:让安全意识渗透到每一位员工

安全不只是一套技术,更是一种组织文化。只有当每位员工都将安全视作日常工作的一部分,才能让治理与技术落到实处。以下是培养安全文化的关键路径:

- 安全意识积分制:通过每月的安全学习、案例复盘、渗透演练等活动获取积分,积分可兑换培训名额或内部资源。

- 全员安全 “情境剧”:围绕真实案例(如 Prompt Injection)编排情境模拟,让员工在角色扮演中体会风险。

- “安全大使”计划:选拔业务骨干成为部门安全大使,负责在业务会议中提醒安全要点,并收集业务层面的安全需求。

- 持续学习平台:搭建内部学习管理系统(LMS),提供 AI 安全、数据治理、合规法规等微课,支持随时学习、随时复习。

四、邀请函:点燃安全学习的热情,携手迎接信息安全意识培训

亲爱的同事们,

在数字浪潮汹涌而来的今天,安全已经不再是 IT 部门的独角戏,而是全体员工的共同使命。上文的三个案例——从 Prompt 注入到模型偏见,再到 Agent‑to‑Agent 的连锁失控——都是我们可能身边随时上演的真实剧本。它们提醒我们:每一次不经意的输入、每一次轻率的数据共享,都可能在无形中为攻击者敞开大门。

为帮助大家提升安全防护能力,昆明亭长朗然科技有限公司将于 2025 年 12 月 5 日(周五)上午 10:00 正式启动信息安全意识培训系列课程。培训内容包括:

- AI 安全基础:Prompt 防护、模型可信度评估、数据偏见检测。

- 零信任实战:Agent‑to‑Agent 的最小权限设计、API 访问审计。

- 合规与治理:《个人信息保护法》与《网络安全法》在 AI 场景下的落实路径。

- 案例复盘工作坊:现场演练 Prompt 注入渗透测试,实践安全编码与审计。

- 安全文化建设:如何在日常工作中落实“安全先行”。

本次培训采用线上+线下混合模式,线上直播同步录播,线下现场提供互动实验环境,旨在以“做中学、学中做”的方式,让每位同事都能在真实的业务场景中体会安全防护的重要性。

温馨提示

1. 请提前在内部论坛报名,名额有限,先到先得。

2. 培训结束后,将发放《信息安全合规手册》电子版,供大家随时参考。

3. 培训期间将设置安全挑战赛,累计积分最高的团队将获得公司提供的 AI 安全实验套件(包含安全加固工具、数据脱敏脚本),帮助业务快速落地安全实践。

让我们 以案例为镜,以培训为桥,在技术、治理、文化三方面共同筑牢企业的数字疆界。无论您是研发工程师、业务运营、财务审计,亦或是行政后勤,每一位同事都是安全防线的重要节点。请把握机会,积极参与培训,用专业的安全意识为公司的创新之路保驾护航。

引用古语:“防微杜渐,得天下之安”。我们要在细枝末节中发现风险,在潜移默化中培养安全意识,让每一次微小的防护,都成为守护公司全局的坚实基石。

让安全成为我们共同的语言,让信任成为企业最坚固的基石!

期待在培训现场与您相聚,共同开启安全新篇章!

昆明亭长朗然科技有限公司通过定制化的信息安全演练课程,帮助企业在模拟场景中提高应急响应能力。这些课程不仅增强了员工的技术掌握度,还培养了他们迅速反应和决策的能力。感兴趣的客户欢迎与我们沟通。

- 电话:0871-67122372

- 微信、手机:18206751343

- 邮件:info@securemymind.com

- QQ: 1767022898