Ⅰ、头脑风暴:两个警示深刻的安全事件

在信息安全的海洋里,若不提前设下警示灯塔,船只极易在暗流中触礁。下面,我将以两桩真实且极具教育意义的案例为例,进行一次全方位的“头脑风暴”。这些案例并非遥不可及的新闻,它们或许就在我们身边的工作台、会议室、甚至是咖啡机旁的聊天窗口里上演。

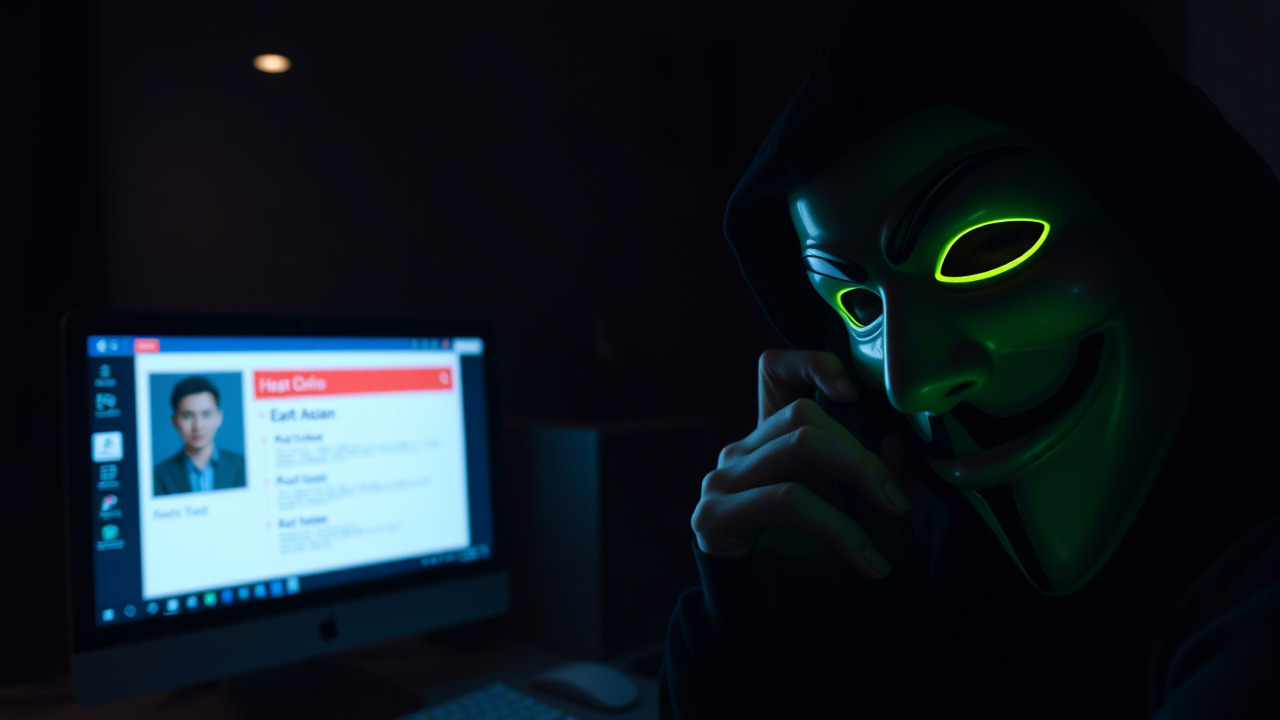

案例一:Ericsson 供应商“声线钓鱼”案——一通电话撬开千余条个人记录

2025 年 4 月,一名不经意的供应商员工在接到自称是 Ericsson 安全部门的来电时,心软了。攻击者利用vishing(语音钓鱼)手法,假冒内部审计人员,声称需要临时核验系统账号与密码,以配合“紧急安全检查”。员工在慌乱与信任的双重驱动下,泄露了包含 姓名、社会安全号、驾照号、护照号 以及 银行卡信息 在内的敏感数据。事后调查显示,攻击者在 4 月 17 日至 22 日 的五天窗口内,成功获取了 15,661 名美国用户的个人信息。

“祸从口出,恶从声来”。这句古语在现代网络安全中被重新诠释:一次电话的疏忽,即可导致上万条记录的泄露。这起事件提醒我们:人是防线最薄弱的环节,尤其在多租户、外包深耕的供应链环境中。

案例二:EV 充电网络被勒索——“机器人”被操纵为黑客的“马前卒”

2024 年底,欧洲一家知名电动车充电运营商 ELECQ 遭遇勒索软件攻击。攻击者通过渗透其内部 IoT 充电桩管理平台,植入后门并锁定了 超过 30 万台充电桩 的控制权。更让人胆寒的是,黑客利用 机器人流程自动化(RPA) 脚本,批量导出用户的联系方式、支付凭证与行驶里程数据,随后以 “若不付赎金,充电站将全部关闭” 为威胁,向全球数十万车主勒索巨额比特币。

正如《孙子兵法》所言:“兵者,诡道也”。在数字化、机器人化的今日,黑客的“军队”已经不再是人,而是代码、机器人与 AI。一次系统漏洞的失守,便可能让成千上万的物联网设备在黑客的指挥棒下,成为“数字化幽灵”,危害用户隐私与公共安全。

Ⅱ、案例剖析:从技术漏洞到人性弱点的全链路复盘

1. 攻击路径的共性——“社会工程”是第一道门

无论是 vishing 还是 利用 RPA 脚本的自动化渗透,背后都离不开 社会工程 这把“钥匙”。攻击者首先通过信息收集(如 LinkedIn、公司内部通讯录),确定目标人物的职务、职责与心理状态,随后使用诱导式对话或紧急任务的幌子,迫使受害者在无防备的瞬间泄露凭证或执行恶意指令。

“欲擒故纵,声色俱厉”。现代黑客借助 AI 生成自然语言,甚至可以模拟真实语音、面部表情,让受害者误以为是内部同事或上级,陷入“信任陷阱”。这对我们每一位职员都是一次严峻的警示:任何未经核实的请求,都必须通过多因素验证。

2. 技术环节的薄弱——系统权限与自动化工具的失控

在 ELECQ 案例中,攻击者利用了内部 API 接口的弱授权,配合 RPA 机器人 实现批量数据抽取。传统的防火墙、入侵检测系统(IDS)在面对 合法身份的机器人行为 时,往往难以辨别异常;而 AI 驱动的攻击 更是能够自适应防御措施,迅速变换攻击手法。

“兵贵神速”。防御同样需要速度与智能的结合:部署 行为分析(UEBA)、机器学习异常检测,并对 关键 API 实施 细粒度访问控制(ABAC),才能在机器人化的攻击面前保持先机。

3. 供应链安全的盲区——外包伙伴亦是攻击入口

Ericsson 案例的根本原因在于 供应链缺乏统一的安全治理。第三方服务商的 安全培训、评估与审计 未能同步到位,导致内部安全意识的差距被利用。现实中,越是外部合作越紧密,安全风险越是隐蔽。

“合则两利,离则两害”。企业必须在 合作协议 中明确 安全责任划分,并通过 供应链风险管理平台(SCRM) 实现 持续监控、及时预警,将外包风险纳入整体防御体系。

Ⅲ、机器人化、数字化、具身智能化的融合——安全的“新战场”

1. 机器人化:从单机 RPA 到协同 AI 机器人

随着 大模型 AI 与 边缘计算 的成熟,企业正加速部署 协同式机器人:自动化客服、智能巡检、生产线自适应调度……这些机器人拥有 自主学习、决策与执行 能力,同时也成为 攻击者的远程操控平台。一旦机器人被劫持,不仅 业务中断,更可能 泄露数百万条数据。

2. 数字化:全域感知的双刃剑

企业数字化转型意味着 业务数据、运营日志、用户画像 全面上云、全链路可视化。数据价值提升的同时,攻击面也随之扩大:从 数据库泄露 到 云原生容器逃逸,每一层都可能成为黑客的突破口。

3. 具身智能化:人机交互的沉浸式体验

具身智能(Embodied Intelligence)让人们通过 AR/VR、可穿戴设备、体感交互 与系统交互。此类交互方式在提升工作效率的同时,也带来了 身份伪造、传感器数据篡改 等新型威胁。例如,黑客可以通过 伪造 AR 视图,诱导员工执行错误的操作指令。

正如《庄子·齐物论》所说:“天地与我并生,而万物与我为一”。在信息安全的格局里,人、技术、环境已经形成一个不可分割的整体,任何单点的薄弱都可能导致全链路的崩溃。

Ⅳ、呼吁行动:加入信息安全意识培训,共筑“人‑机‑链”防线

1. 培训的意义——从“被动防御”到“主动防护”

传统的安全培训往往停留在 口号式的“不要随便点链接”,缺乏 情境化、交互式的实战演练。在机器人化、数字化、具身智能化的融合环境中,我们需要 “情境式安全教育”:通过 模拟电话钓鱼、红队对抗、AI 诱骗 等场景,让职工在真实威胁中学习防御技巧。

2. 培训的内容——覆盖技术、流程与心理三大维度

- 技术层面

- 云原生安全基线(CI/CD 安全、容器安全)

- 行为分析与机器学习异常检测原理

- 多因素身份验证(MFA)与零信任架构(ZTNA)

- 流程层面

- 供应链安全审计与风险评估流程

- 事故响应(IR)标准作业程序(SOP)

- 数据分类与加密、备份与恢复最佳实践

- 心理层面

- 社会工程识别技巧(vishing、phishing、smishing)

- “认知偏差”防御模型(确认偏误、从众效应)

- 高压情境下的决策训练(情境模拟)

3. 培训方式——多元化、沉浸式、可持续

- 线上微课堂:每周 10 分钟的“安全快闪”,结合短视频、漫画、互动测验,强化记忆。

- 现场情景演练:搭建模拟电话中心、假冒邮件平台,邀请职工现场“破局”。

- AI 导览伙伴:部署企业内部的 安全助理机器人,提供实时风险提示、疑难解答。

- VR 防御实战:利用 虚拟现实 场景,重现网络攻击全链路,让员工体验从检测到响应的完整过程。

4. 组织保障——全员、全程、全链的安全治理

- 全员参与:从高层管理者到基层操作员,均需完成安全培训,并通过考核。

- 全程监控:利用 安全信息与事件管理系统(SIEM) 与 用户行为分析(UEBA),对培训后行为变化进行跟踪评估。

- 全链闭环:将培训成果嵌入 供应链安全合约、外包审计、项目交付标准,形成闭环管理。

“千里之堤,溃于蚁穴”。只有让每一位职工都成为 安全的第一道防线,才能真正抵御不断升级的攻击手段。

Ⅴ、行动计划:从今天起,让安全成为工作习惯

| 时间 | 活动 | 目标 |

|---|---|---|

| 3 月 20 日 | 启动仪式(高层致辞、案例分享) | 提升全员安全意识 |

| 3 月 21‑30 日 | 线上微课堂(每日 1 条安全小贴士) | 建立安全思维 |

| 4 月第一周 | 情景演练(电话钓鱼、RPA 渗透) | 实战演练,检验防御能力 |

| 4 月中旬 | VR 实战(攻击链全景演示) | 沉浸式学习,强化记忆 |

| 5 月 | 内部安全大赛(红蓝对抗) | 激发创新防御思路 |

| 6 月 | 评估报告(培训成效、行为改善) | 实证效果,持续改进 |

我们的期望

- 90% 以上职工完成全部培训模块并通过终评。

- 供应链安全审计 合规率提升至 95% 以上。

- 安全事件响应时间 缩短 50%,实现 提前预警、快速处置。

正如宋代名将戚繇所言:“兵者,国之大事,死生之地,存亡之务”。在信息化的今天,信息安全 已经成为企业的 “国之大事”,是决定生死存亡的关键。让我们以技术为剑、以培训为盾,在机器人化、数字化、具身智能化的浪潮中,砥砺前行,守护企业的每一份数据、每一次交易、每一个信任。

结语:

安全不是一次性的任务,而是一场 持续的文化建设。只有当每个人都把 “不轻信来电、不随意点链接、发现异常即时上报” 融入到日常工作与生活的细节中,才能在纷繁复杂的数字生态里,筑起一道坚不可摧的防线。让我们携手共进,在即将开启的信息安全意识培训中,以智慧与勇气迎接挑战,为企业的可持续发展保驾护航!

让安全成为习惯,让防护随时随地!

在昆明亭长朗然科技有限公司,我们不仅提供标准教程,还根据客户需求量身定制信息安全培训课程。通过互动和实践的方式,我们帮助员工快速掌握信息安全知识,增强应对各类网络威胁的能力。如果您需要定制化服务,请随时联系我们。让我们为您提供最贴心的安全解决方案。

- 电话:0871-67122372

- 微信、手机:18206751343

- 邮件:info@securemymind.com

- QQ: 1767022898